Содержание

- 2. Лекция 1. Теоретические основы информатики. Основные понятия информатики и информатизации. Понятие информации, общая характеристика процессов сбора,

- 3. Основные понятия под информатикой можно понимать науку о вычислениях, хранении и обработке информации. информационное общество –

- 4. Отличительными чертами информационного общества являются: – увеличение роли информации и знаний в жизни общества; – возрастание

- 5. Основные понятия Процесс проникновения информационных технологий во все сферы жизни и деятельности общества называется процессом информатизации

- 6. Понятие информации, общая характеристика процессов сбора, передачи, обработки и накопления информации Информация – от латинского informatio

- 7. Понятие информации, общая характеристика процессов сбора, передачи, обработки и накопления информации информация – сведения (сообщения, данные)

- 8. Понятие информации, общая характеристика процессов сбора, передачи, обработки и накопления информации Информация классифицируется: 1. По способам

- 9. Понятие информации, общая характеристика процессов сбора, передачи, обработки и накопления информации Информация – мера устранения неопределенности

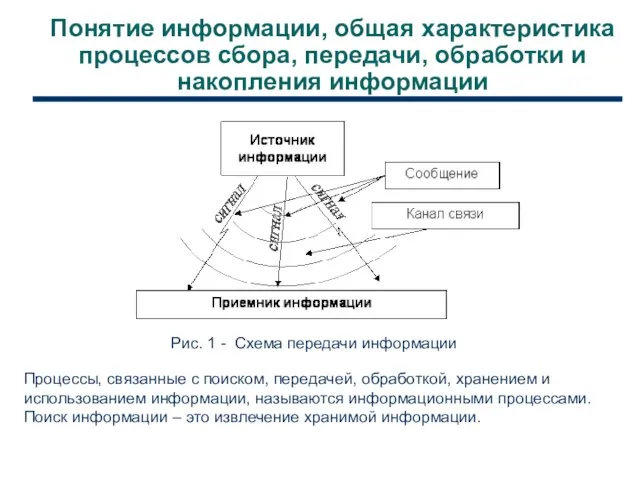

- 10. Понятие информации, общая характеристика процессов сбора, передачи, обработки и накопления информации Рис. 1 - Схема передачи

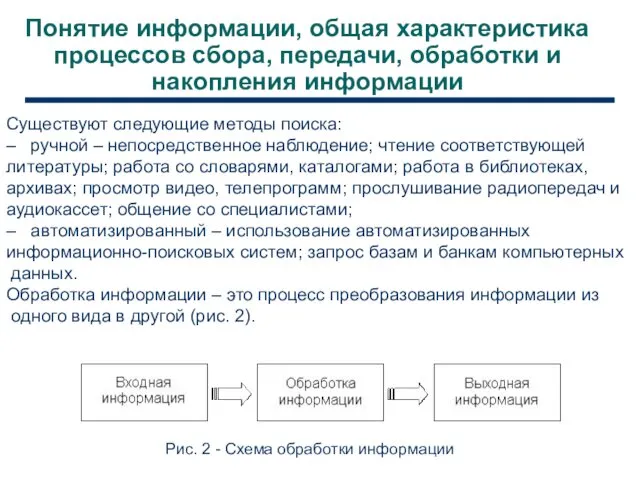

- 11. Понятие информации, общая характеристика процессов сбора, передачи, обработки и накопления информации Существуют следующие методы поиска: –

- 12. Понятие информации, общая характеристика процессов сбора, передачи, обработки и накопления информации Обработка информации может происходить: а)

- 13. Форма представления информации в компьютере. Единицы измерения Хранение и обработка информации реализованы в двоичных кодах с

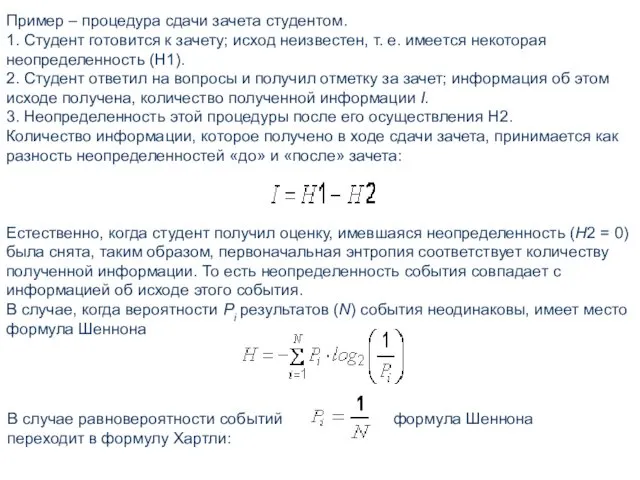

- 14. Пример – процедура сдачи зачета студентом. 1. Студент готовится к зачету; исход неизвестен, т. е. имеется

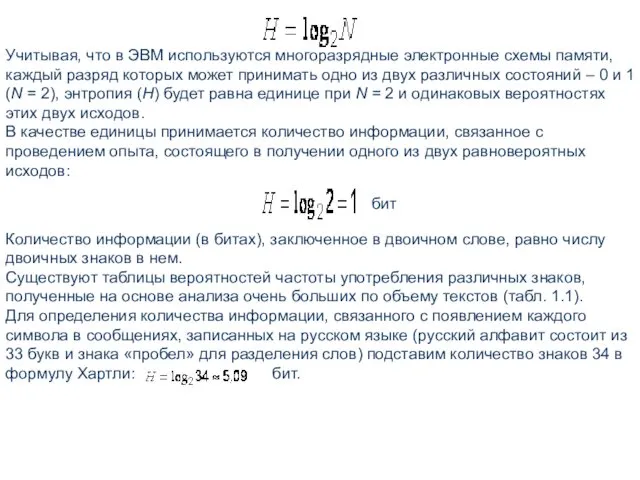

- 15. Учитывая, что в ЭВМ используются многоразрядные электронные схемы памяти, каждый разряд которых может принимать одно из

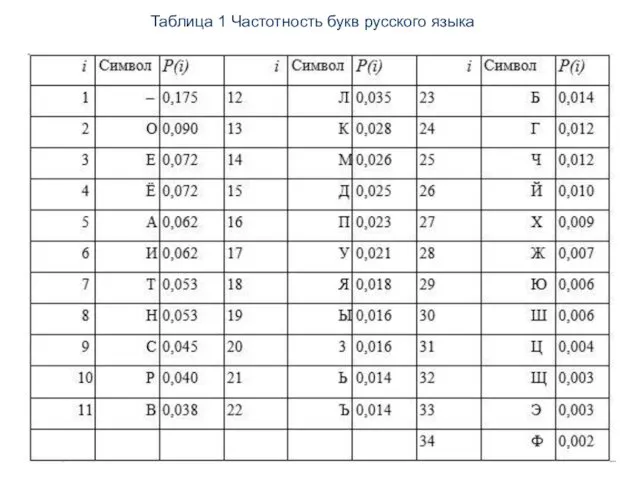

- 16. Таблица 1 Частотность букв русского языка

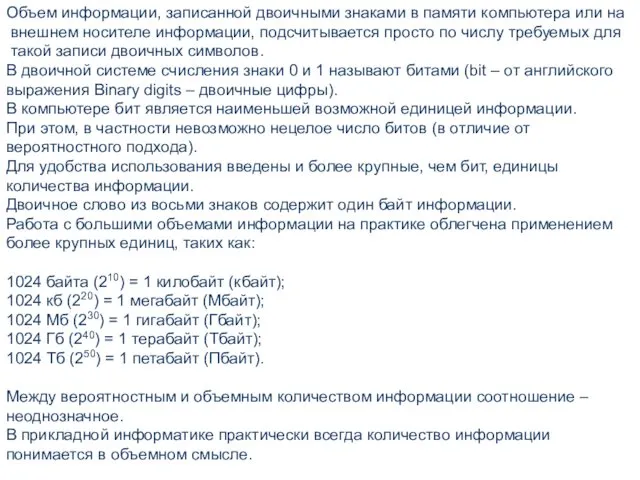

- 17. Объем информации, записанной двоичными знаками в памяти компьютера или на внешнем носителе информации, подсчитывается просто по

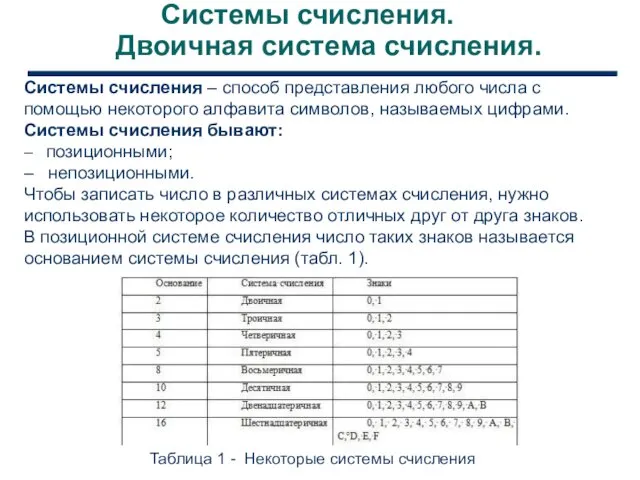

- 18. Системы счисления. Двоичная система счисления. Системы счисления – способ представления любого числа с помощью некоторого алфавита

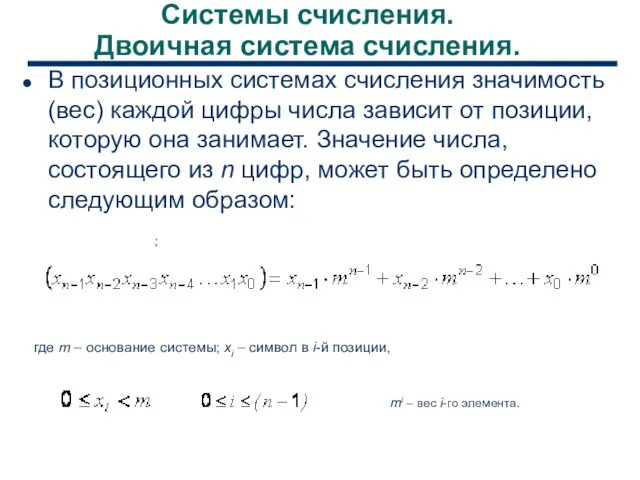

- 19. Системы счисления. Двоичная система счисления. В позиционных системах счисления значимость (вес) каждой цифры числа зависит от

- 21. Скачать презентацию

Моделирование статистического прогнозирования. Прогнозирование по регрессионной модели

Моделирование статистического прогнозирования. Прогнозирование по регрессионной модели Бесплатные антивирусные программы

Бесплатные антивирусные программы Полигональное моделирование

Полигональное моделирование Принципы технологии модерации.

Принципы технологии модерации. Кітапхана-баспа орталығы ҚМУ КеАҚ кітапхана-баспа орталығының электрондық оқу басылымдарының

Кітапхана-баспа орталығы ҚМУ КеАҚ кітапхана-баспа орталығының электрондық оқу басылымдарының Створення таблиць, форм, запитів і звітів

Створення таблиць, форм, запитів і звітів Все о кассовой дисциплине или онлайн-кассы для чайников

Все о кассовой дисциплине или онлайн-кассы для чайников Кодирование графифической информации

Кодирование графифической информации Использование вашего приложения

Использование вашего приложения Cybersecurity

Cybersecurity Github workflow

Github workflow Шаблон презентации проекта

Шаблон презентации проекта Инструменты графического редактора. Начинаем рисовать. 5 класс

Инструменты графического редактора. Начинаем рисовать. 5 класс Брутфорс. Взлом учетных записей в компьютерных системах

Брутфорс. Взлом учетных записей в компьютерных системах Processes and threads. (Chapter 2)

Processes and threads. (Chapter 2) Kofax Transformation Modules 5. Introduction to Class Training

Kofax Transformation Modules 5. Introduction to Class Training Организация работы детей старшего дошкольного возраста в освоении ИКТ технологий

Организация работы детей старшего дошкольного возраста в освоении ИКТ технологий MS Word. Редактирование документа

MS Word. Редактирование документа Ауқымды компьютерлік желі - Интернет

Ауқымды компьютерлік желі - Интернет Переключательная схема (презентация)

Переключательная схема (презентация) Конспект урока Базовое программное обеспечение с мультимедийным сопровождением

Конспект урока Базовое программное обеспечение с мультимедийным сопровождением Как работает современный поиск

Как работает современный поиск Эффективное кодирование информации

Эффективное кодирование информации Основы медицинской информации и научной библиографии

Основы медицинской информации и научной библиографии Проблемы и перспективы развития рынка информации в России

Проблемы и перспективы развития рынка информации в России Основные языки для разработки мобильных приложений

Основные языки для разработки мобильных приложений Концепции системы 1С:Предприятия

Концепции системы 1С:Предприятия 3. Essential Java Classes. 3a. Date and Time in Java SE8

3. Essential Java Classes. 3a. Date and Time in Java SE8