Содержание

- 2. Классы задач, решаемых современными нейросетями: Классификация: распознавание образов, распознавание голосов, верификация подписей, постановка диагноза, анализ экспериментальных

- 4. Нейронные сети РЕАЛЬНЫЙ НЕЙРОН

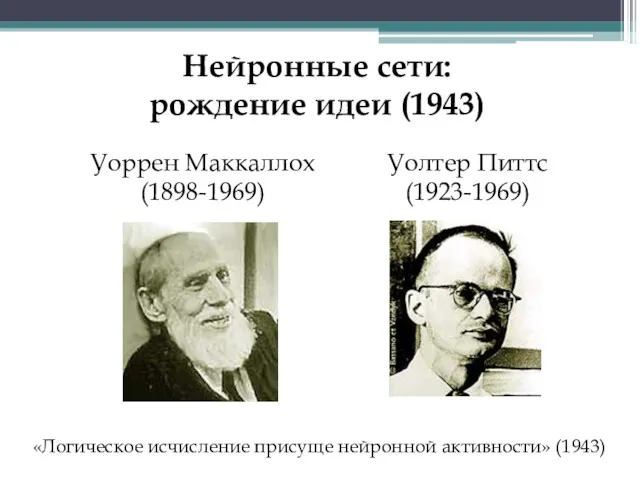

- 5. Нейронные сети: рождение идеи (1943) Уоррен Маккаллох (1898-1969) Уолтер Питтс (1923-1969) «Логическое исчисление присуще нейронной активности»

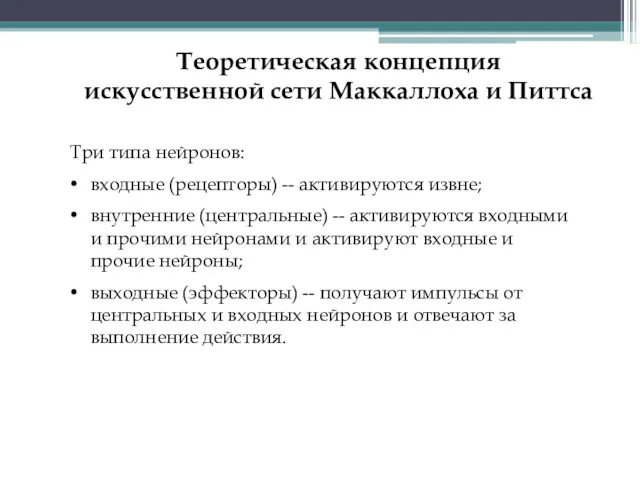

- 6. Три типа нейронов: входные (рецепторы) -- активируются извне; внутренние (центральные) -- активируются входными и прочими нейронами

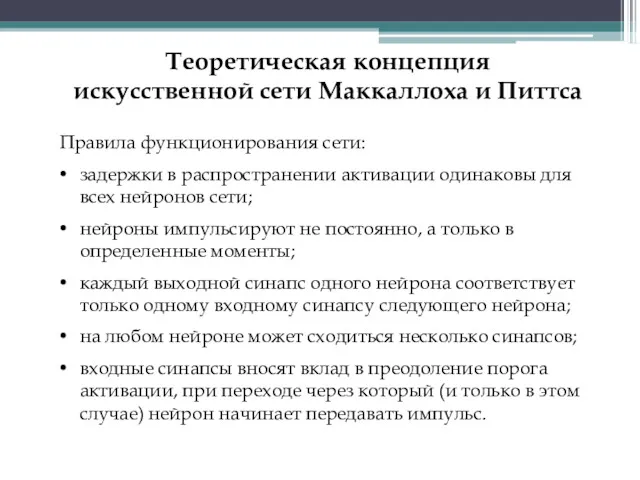

- 7. Теоретическая концепция искусственной сети Маккаллоха и Питтса Правила функционирования сети: задержки в распространении активации одинаковы для

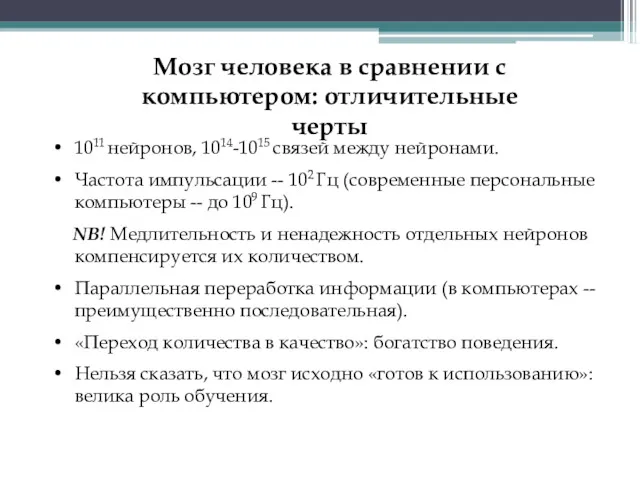

- 8. Мозг человека в сравнении с компьютером: отличительные черты 1011 нейронов, 1014-1015 связей между нейронами. Частота импульсации

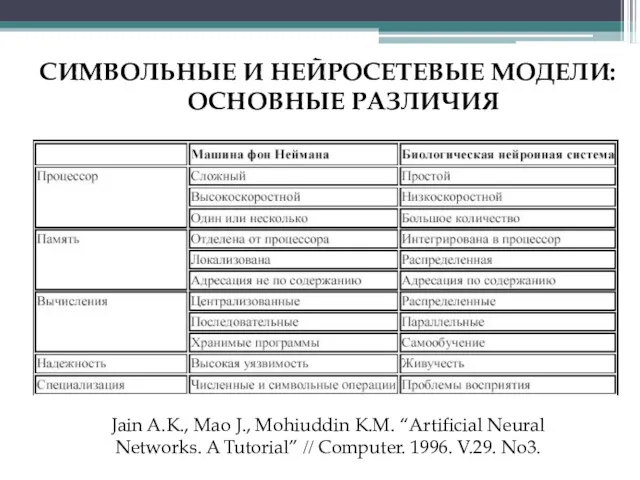

- 9. СИМВОЛЬНЫЕ И НЕЙРОСЕТЕВЫЕ МОДЕЛИ: ОСНОВНЫЕ РАЗЛИЧИЯ Jain A.K., Mao J., Mohiuddin K.M. “Artificial Neural Networks. A

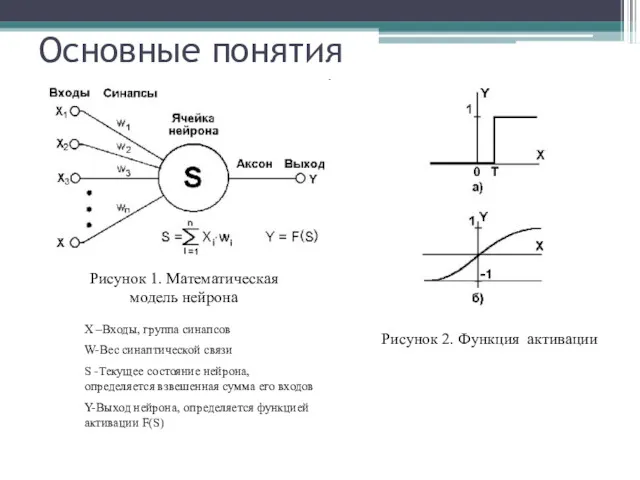

- 10. Основные понятия X –Входы, группа синапсов W-Вес синаптической связи S -Текущее состояние нейрона, определяется взвешенная сумма

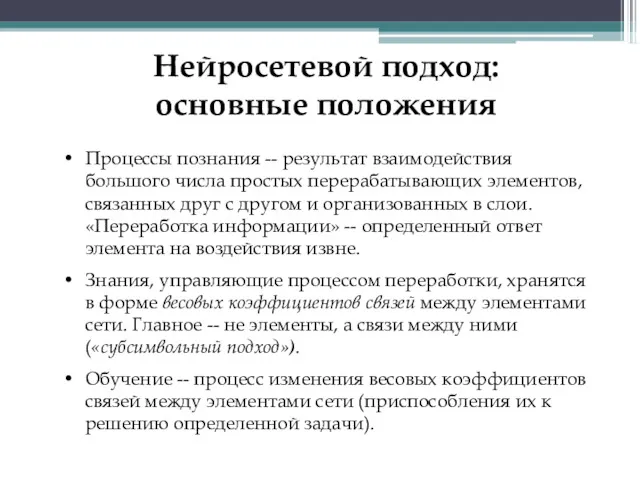

- 11. Нейросетевой подход: основные положения Процессы познания -- результат взаимодействия большого числа простых перерабатывающих элементов, связанных друг

- 12. ОБУЧЕНИЕ НЕЙРОННОЙ СЕТИ Дональд Олдинг Хебб (1904-1985) Итог -- образование «нейронного ансамбля», который все быстрее активируется

- 13. Современные парадигмы обучения нейронных сетей с учителем без учителя Есть готовый ответ Самообучение

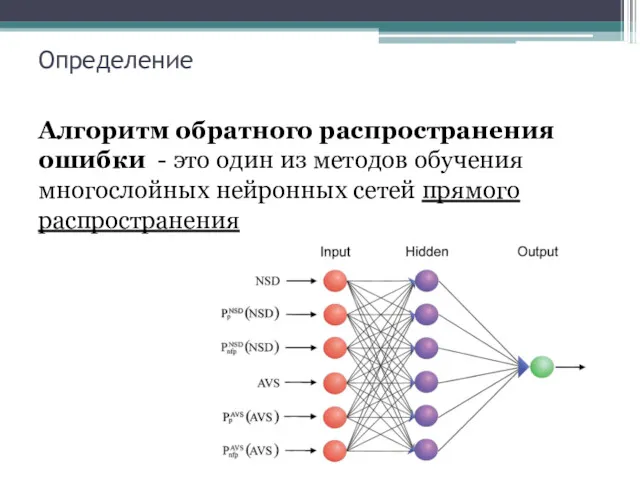

- 14. Определение Алгоритм обратного распространения ошибки - это один из методов обучения многослойных нейронных сетей прямого распространения

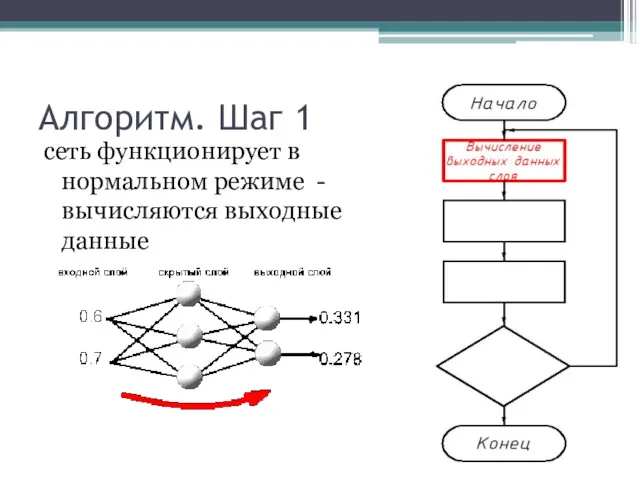

- 15. Алгоритм. Шаг 1 сеть функционирует в нормальном режиме - вычисляются выходные данные

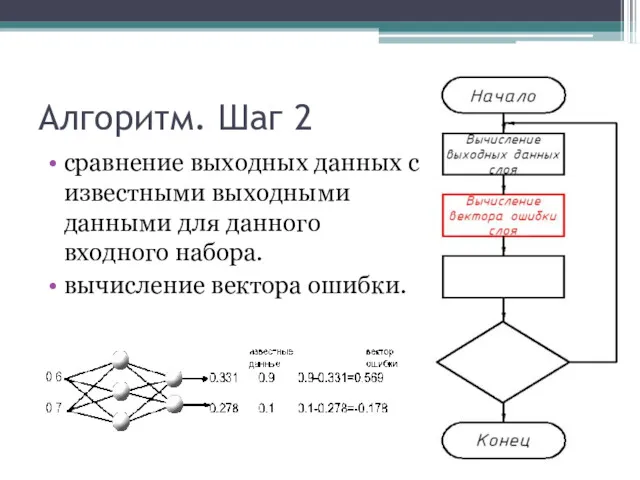

- 16. Алгоритм. Шаг 2 сравнение выходных данных с известными выходными данными для данного входного набора. вычисление вектора

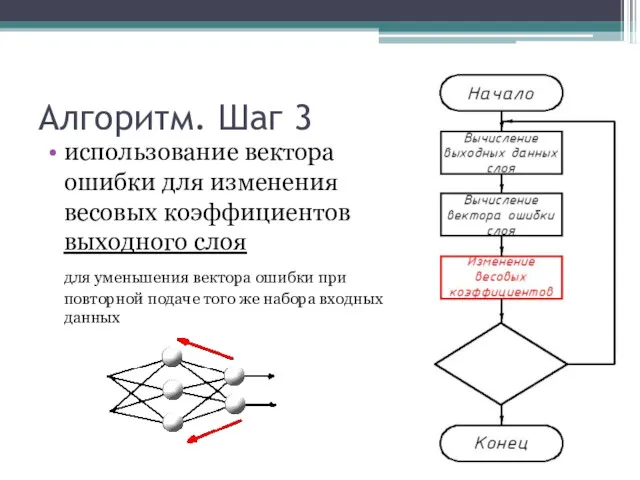

- 17. Алгоритм. Шаг 3 использование вектора ошибки для изменения весовых коэффициентов выходного слоя для уменьшения вектора ошибки

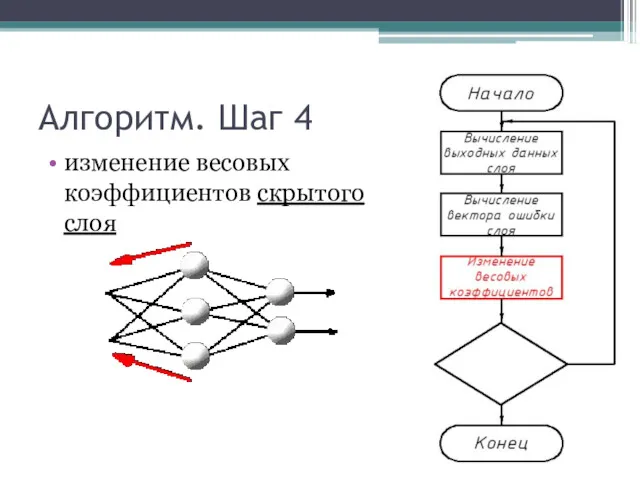

- 18. Алгоритм. Шаг 4 изменение весовых коэффициентов скрытого слоя

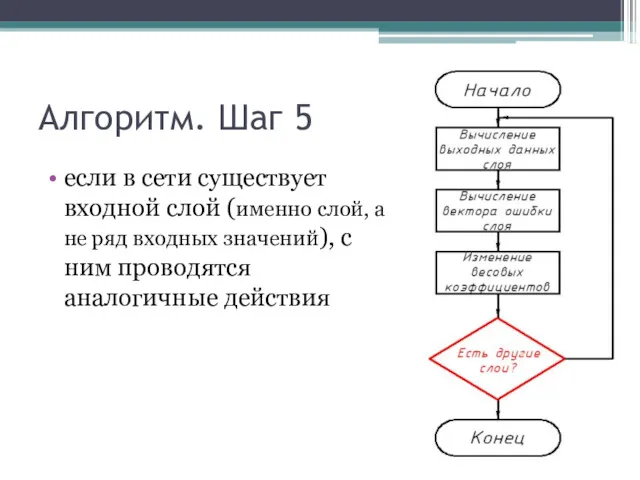

- 19. Алгоритм. Шаг 5 если в сети существует входной слой (именно слой, а не ряд входных значений),

- 20. Особенность обучения сети сеть обучается путем предъявления каждого входного набора данных и последующего распространения ошибки цикл

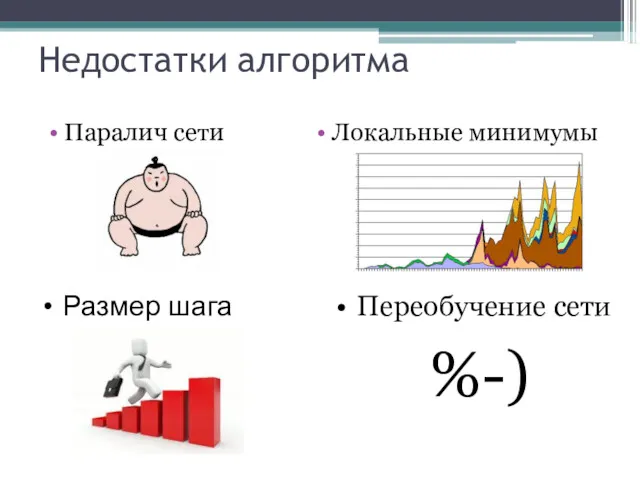

- 21. Недостатки алгоритма Паралич сети Локальные минимумы Размер шага Переобучение сети %-)

- 22. Нейронные сети. Классификатор.

- 23. Постановка Задачи Построить нейронную сеть – классификатор. Сеть распознает представленные ей образы, например графические файлы с

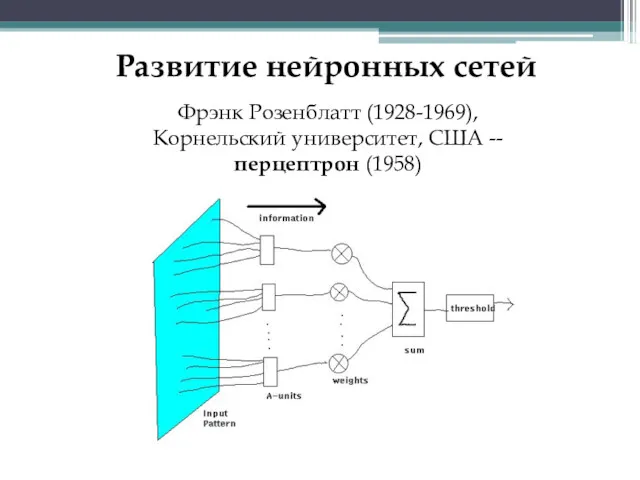

- 24. Развитие нейронных сетей Фрэнк Розенблатт (1928-1969), Корнельский университет, США -- перцептрон (1958)

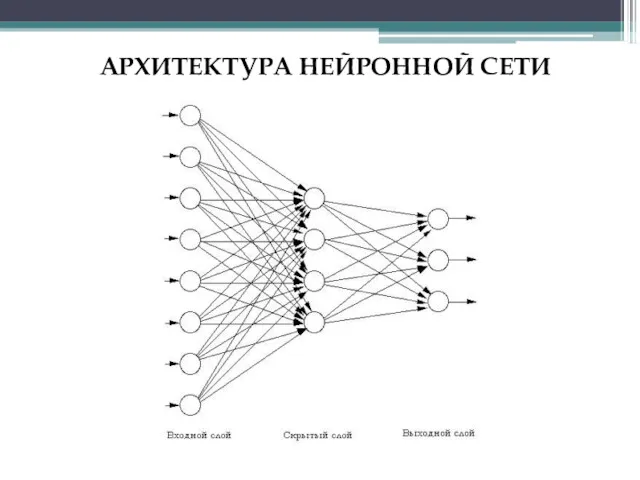

- 25. АРХИТЕКТУРА НЕЙРОННОЙ СЕТИ

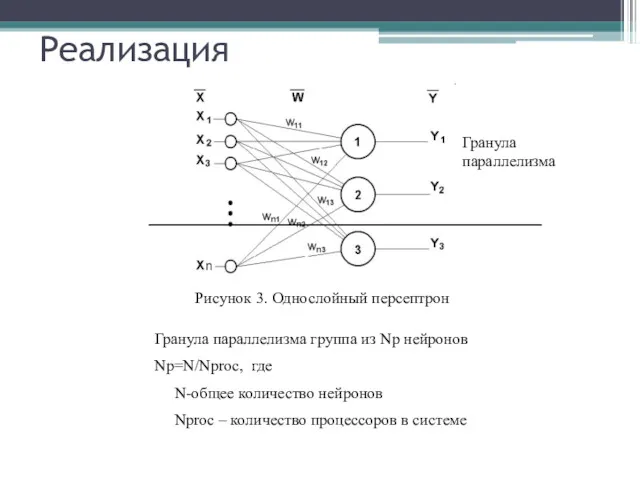

- 26. Реализация Гранула параллелизма группа из Np нейронов Np=N/Nproc, где N-общее количество нейронов Nproc – количество процессоров

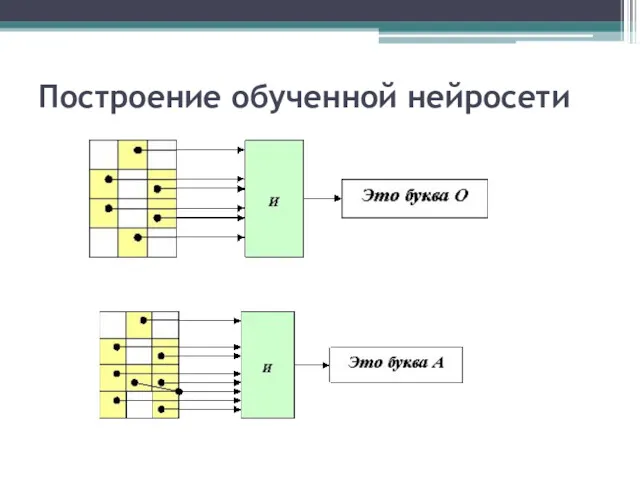

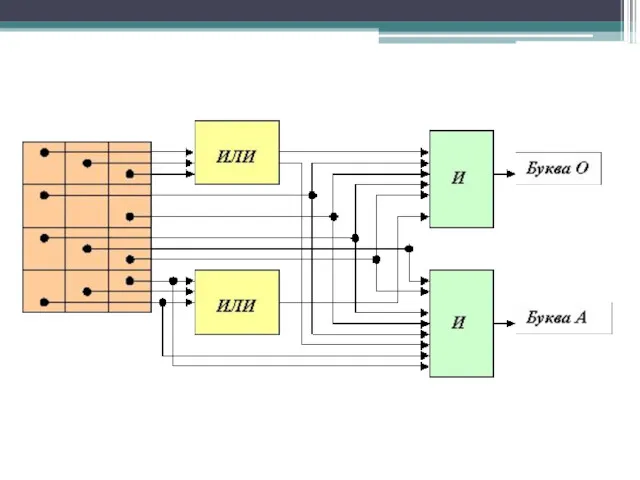

- 27. Построение обученной нейросети

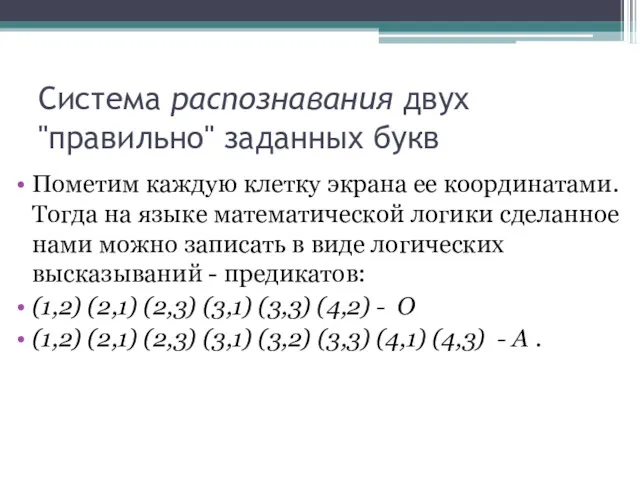

- 28. Система распознавания двух "правильно" заданных букв Пометим каждую клетку экрана ее координатами. Тогда на языке математической

- 29. Но что делать, если буквы на экране пишутся дрожащей рукой? Тогда мы должны разрешить альтернативную засветку

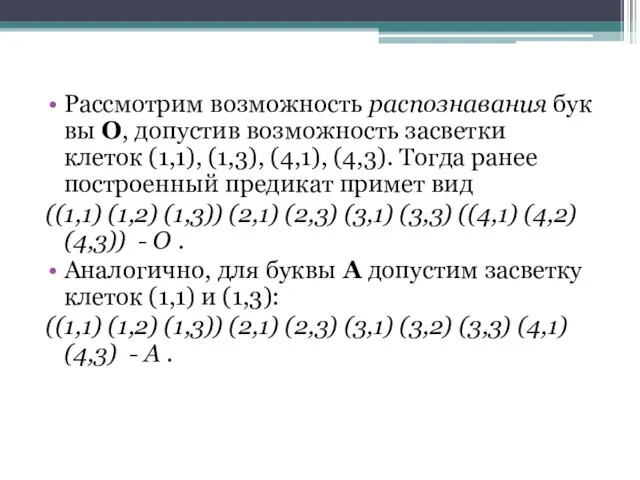

- 30. Рассмотрим возможность распознавания буквы О, допустив возможность засветки клеток (1,1), (1,3), (4,1), (4,3). Тогда ранее построенный

- 32. Проблемы реализации и их решение Проблемы: Большой объем передачи данных Малая вычислительная сложность гранул параллелизма Решение:

- 34. Скачать презентацию

Комплексная оценка эффективности финансовохозяйственной деятельности предприятия. Лекция 1

Комплексная оценка эффективности финансовохозяйственной деятельности предприятия. Лекция 1 Организация деятельности Центрального банка

Организация деятельности Центрального банка Анализ финансового состояния

Анализ финансового состояния Общая характеристика пенсионной системы Российской Федерации

Общая характеристика пенсионной системы Российской Федерации Государственная академическая стипендия

Государственная академическая стипендия Микрофинансовые организации. Микрозаймы и банковские кредиты. (10 класс)

Микрофинансовые организации. Микрозаймы и банковские кредиты. (10 класс) Пенсионное обеспечение сотрудников органов внутренних дел и членов их семей в современных социально-экономических условиях

Пенсионное обеспечение сотрудников органов внутренних дел и членов их семей в современных социально-экономических условиях Характеристика и виды налогов

Характеристика и виды налогов Professional activity in the stock market

Professional activity in the stock market Что такое деньги и бюджет

Что такое деньги и бюджет Состав и характеристика источников финансирования

Состав и характеристика источников финансирования Фондовая биржа

Фондовая биржа Анализ страховой фирмы Адонис

Анализ страховой фирмы Адонис Оценка финансового состояния организации. Тема 8

Оценка финансового состояния организации. Тема 8 Инфраструктура рынка ценных бумаг

Инфраструктура рынка ценных бумаг Финансы. Сущность, функции, роль

Финансы. Сущность, функции, роль Tukey’s 1-Degree of Freedom for Non-Additivity/ Yields for 8 Business Indices Over 18 Years

Tukey’s 1-Degree of Freedom for Non-Additivity/ Yields for 8 Business Indices Over 18 Years Учет текущих операций и расчетов на примере ООО Галла К

Учет текущих операций и расчетов на примере ООО Галла К Понятие, предмет, метод, система и источники права социального обеспечения

Понятие, предмет, метод, система и источники права социального обеспечения Финансы. Денежная база и денежная масса

Финансы. Денежная база и денежная масса Функционально-стоимостный анализ

Функционально-стоимостный анализ Кредит и его роль в экономике

Кредит и его роль в экономике Порядок формирования цен в общественном питании

Порядок формирования цен в общественном питании Фьючерсные стратегии

Фьючерсные стратегии Теоретические основы и информационное обеспечение финансового менеджмента

Теоретические основы и информационное обеспечение финансового менеджмента Показатели эффективности бизнеса

Показатели эффективности бизнеса Қазіргі жағдайда коммерциялық банктердің қаржылық тұрақтылығын жүйелі талдау

Қазіргі жағдайда коммерциялық банктердің қаржылық тұрақтылығын жүйелі талдау Корпоративная культура (3). Семейная модель корпоративного управления

Корпоративная культура (3). Семейная модель корпоративного управления