Содержание

- 2. КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ 2 Определение Под информацией понимают совокупность сведений о явлениях, процессах, событиях, фактах и

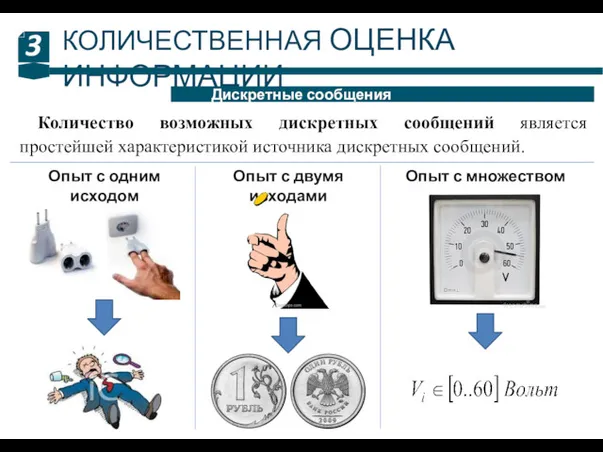

- 3. КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ 3 Дискретные сообщения Количество возможных дискретных сообщений является простейшей характеристикой источника дискретных сообщений.

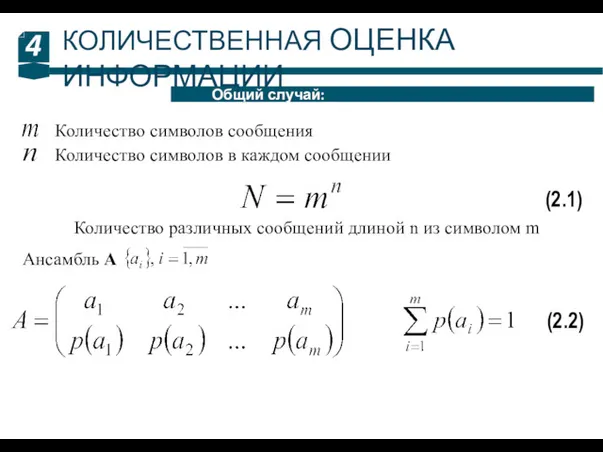

- 4. 4 Общий случай: КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Количество символов сообщения Количество символов в каждом сообщении Количество различных

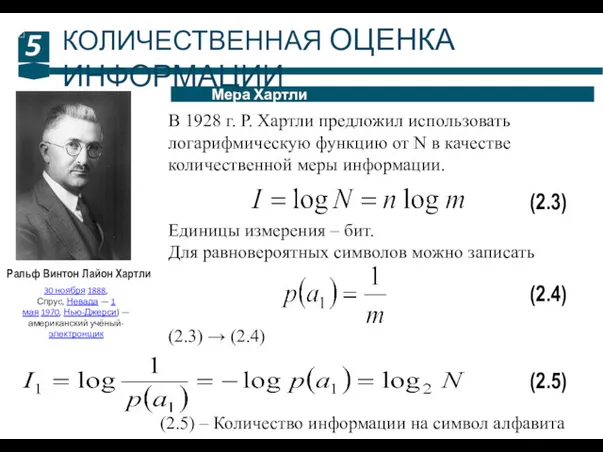

- 5. 5 Мера Хартли КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Ральф Винтон Лайон Хартли 30 ноября 1888, Спрус, Невада —

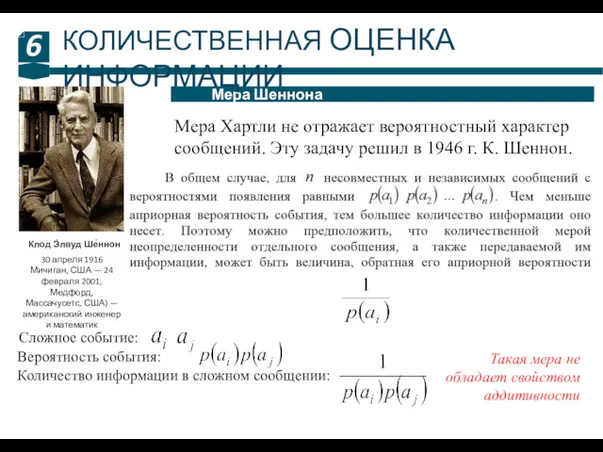

- 6. 6 Мера Шеннона КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Клод Э́лвуд Ше́ннон 30 апреля 1916 Мичиган, США — 24

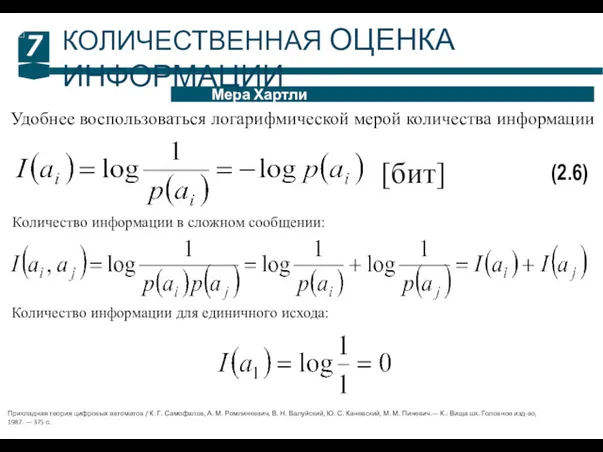

- 7. 7 Мера Хартли КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Удобнее воспользоваться логарифмической мерой количества информации (2.6) Количество информации в

- 8. 8 Частная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.7) [бит/символ] Количество информации и неопределенность для всей совокупности случайных

- 9. 9 Свойства энтропии: КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Чем выше энтропия источника, тем большее количество информации в среднем

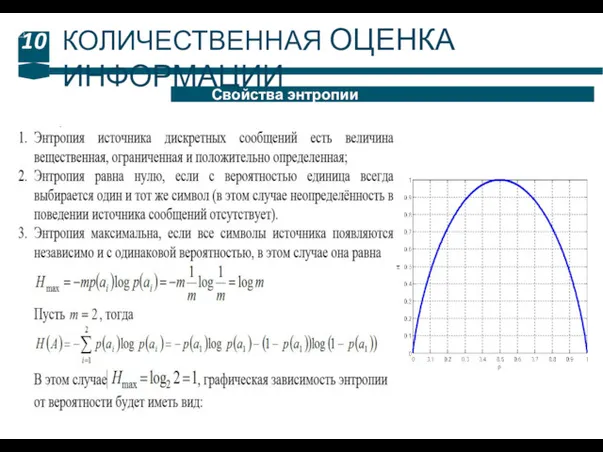

- 10. 10 Свойства энтропии КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ

- 11. 11 Условная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Процесс передачи информации носит случайный характер вероятность появления события X

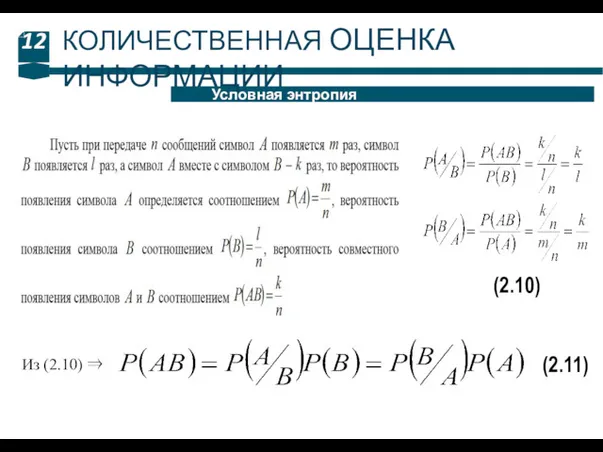

- 12. 12 Условная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.10) Из (2.10) ⇒ (2.11)

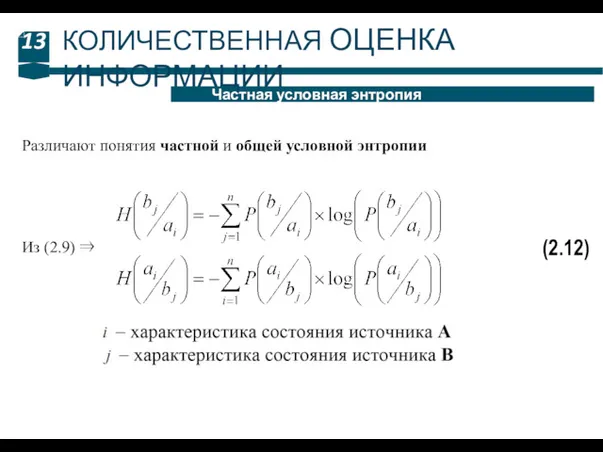

- 13. 13 Частная условная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.12) Из (2.9) ⇒ Различают понятия частной и общей

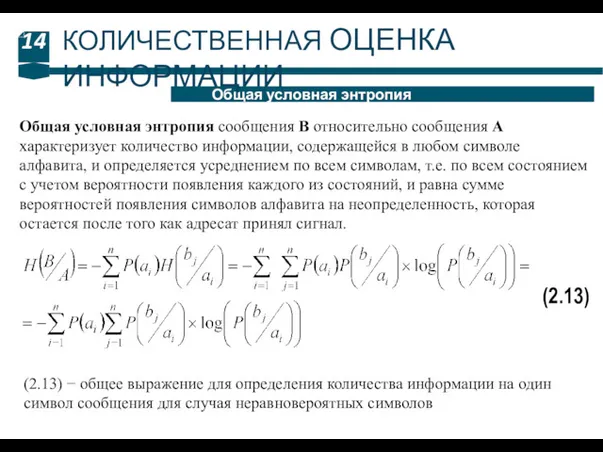

- 14. 14 Общая условная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Общая условная энтропия сообщения B относительно сообщения А характеризует

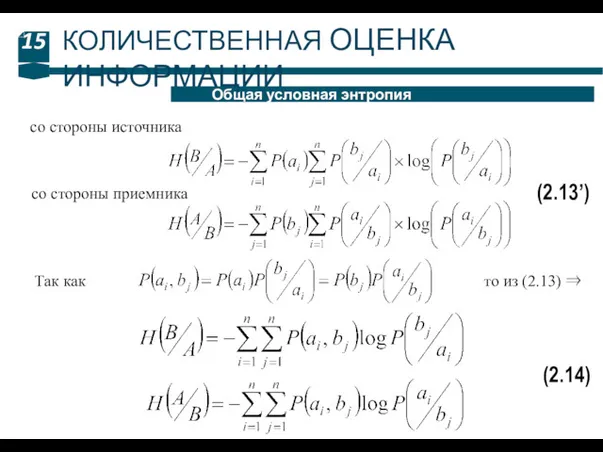

- 15. 15 Общая условная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.13’) со стороны источника со стороны приемника Так как

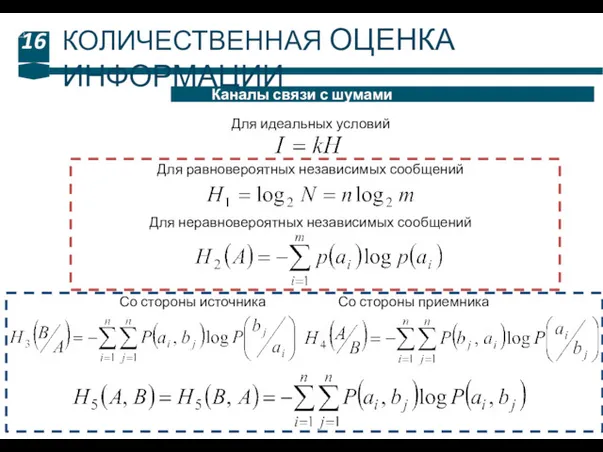

- 16. 16 Каналы связи с шумами КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Для идеальных условий Для равновероятных независимых сообщений Для

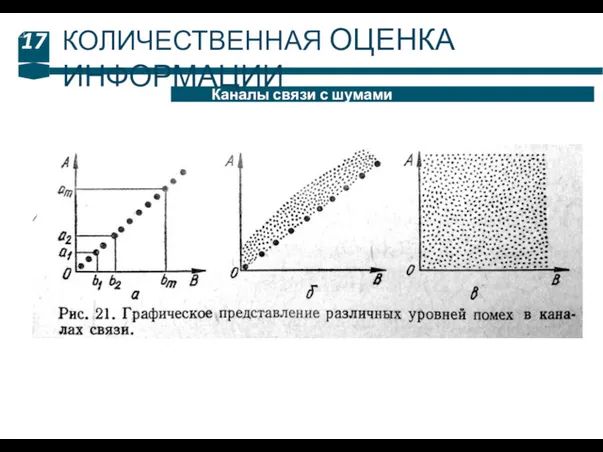

- 17. 17 Каналы связи с шумами КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ

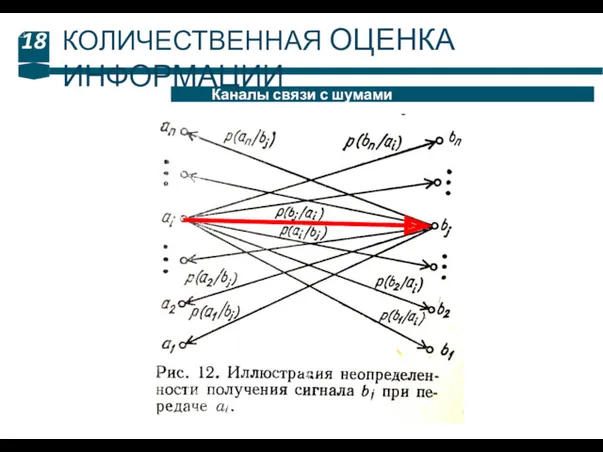

- 18. 18 Каналы связи с шумами КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ

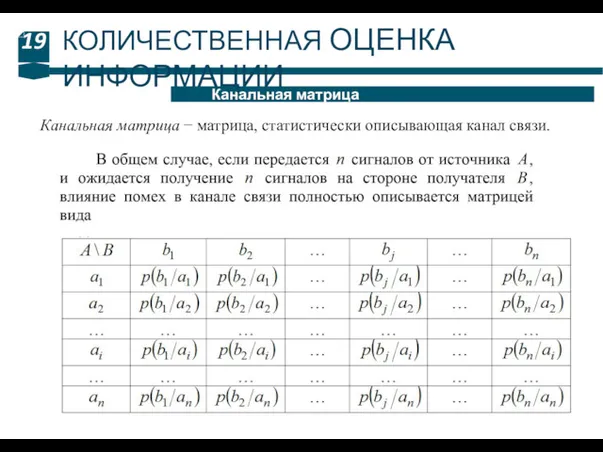

- 19. 19 Канальная матрица КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Канальная матрица − матрица, статистически описывающая канал связи.

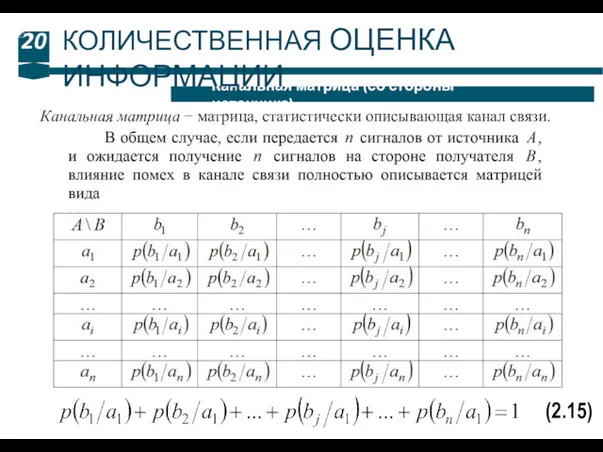

- 20. 20 Канальная матрица (со стороны источника) КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Канальная матрица − матрица, статистически описывающая канал

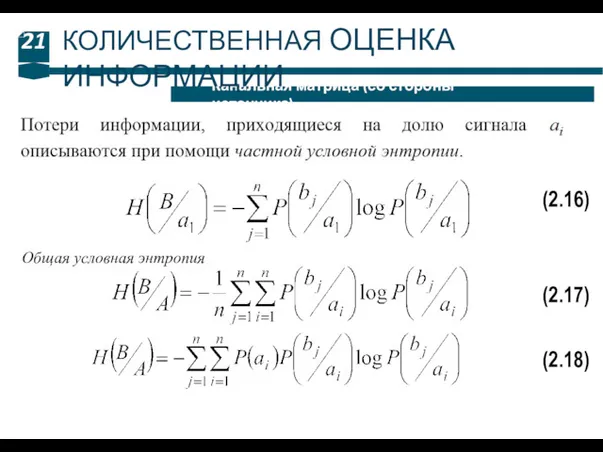

- 21. 21 Канальная матрица (со стороны источника) КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.16) (2.17) Общая условная энтропия (2.18)

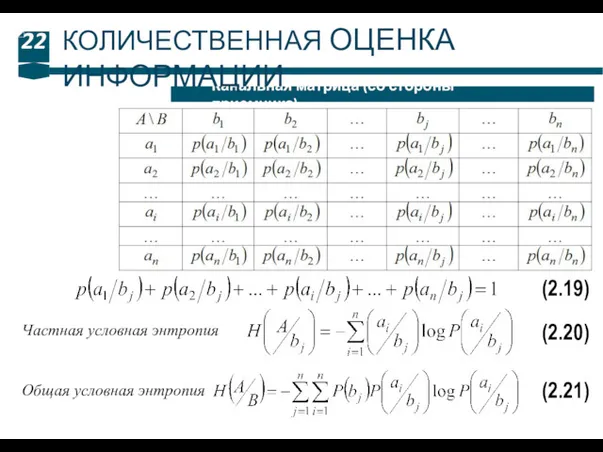

- 22. 22 Канальная матрица (со стороны приемника) КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.19) (2.20) Частная условная энтропия Общая условная

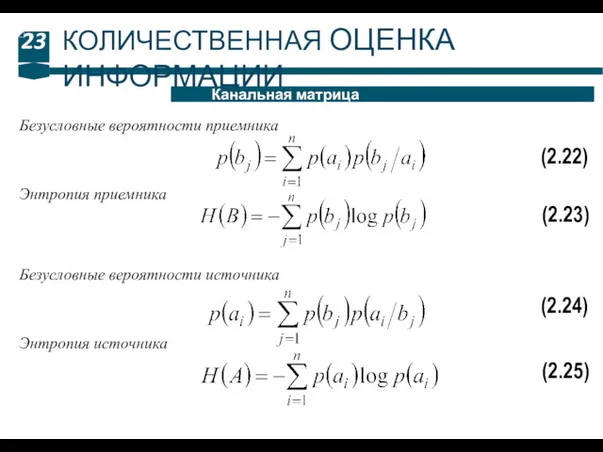

- 23. 23 Канальная матрица КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.22) Безусловные вероятности приемника (2.23) Энтропия приемника (2.24) Безусловные вероятности

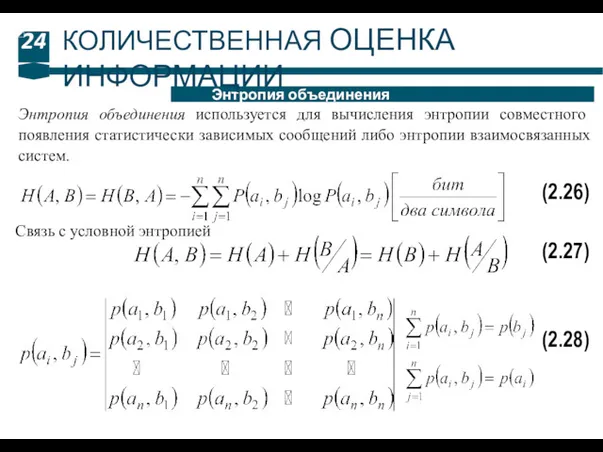

- 24. 24 Энтропия объединения КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ Энтропия объединения используется для вычисления энтропии совместного появления статистически зависимых

- 26. Скачать презентацию

![8 Частная энтропия КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ (2.7) [бит/символ] Количество информации](/_ipx/f_webp&q_80&fit_contain&s_1440x1080/imagesDir/jpg/152517/slide-7.jpg)

Склеивание цепочек

Склеивание цепочек Модели систем

Модели систем Mail Systems and Business Collaboration. (Week 2)

Mail Systems and Business Collaboration. (Week 2) Представление опыта работы по теме: Использование групповых форм работы на уроке информатики

Представление опыта работы по теме: Использование групповых форм работы на уроке информатики Компьютерные СЕТИ (NETWORKS)

Компьютерные СЕТИ (NETWORKS) Целевая аудитория

Целевая аудитория Технологии создания графических изображений

Технологии создания графических изображений Презентация к уроку Электронная почта

Презентация к уроку Электронная почта Многомерные массивы. Структуры и классы. Лекция 4

Многомерные массивы. Структуры и классы. Лекция 4 Операционные системы и сети. (Лекция 1)

Операционные системы и сети. (Лекция 1) Ветвление. Сравнение чисел, переменных

Ветвление. Сравнение чисел, переменных Weekendagency. Live Fest 2020

Weekendagency. Live Fest 2020 Что такое алгоритм. Последовательность действий

Что такое алгоритм. Последовательность действий Игровые методы в преподавании информатики

Игровые методы в преподавании информатики Моделирование составных документов

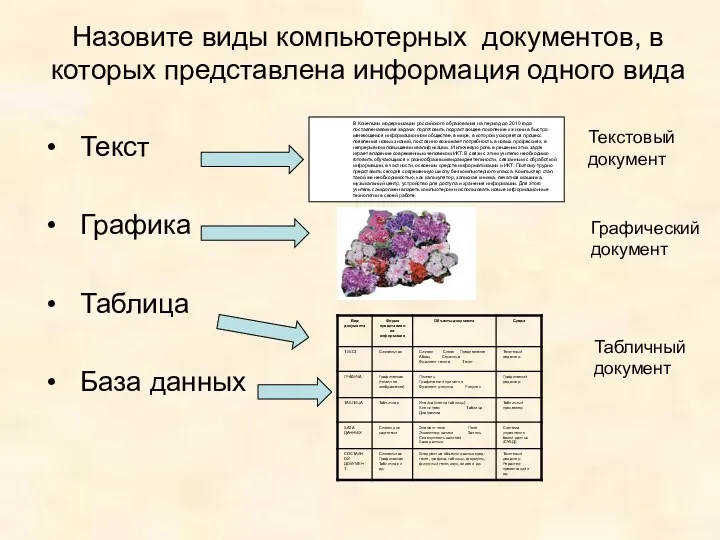

Моделирование составных документов Арифметические операции в позиционных системах счисления (4). 8 класс

Арифметические операции в позиционных системах счисления (4). 8 класс 20231229_9kl_tablitsa

20231229_9kl_tablitsa Думай глобально, действуй локально: экологическое сотрудничество библиотеки

Думай глобально, действуй локально: экологическое сотрудничество библиотеки Створення форм за допомогою конструктора форм

Створення форм за допомогою конструктора форм Табличнный процессор

Табличнный процессор Адресация в сетях TCP IP. Доменные имена

Адресация в сетях TCP IP. Доменные имена Автоматизация делопроизводства

Автоматизация делопроизводства Роль информационной деятельности в современном обществе

Роль информационной деятельности в современном обществе Деректерді ұсыну. Мәтіндік ақпараттарды кодтау принциптері

Деректерді ұсыну. Мәтіндік ақпараттарды кодтау принциптері Различные технологии в 3D-печати

Различные технологии в 3D-печати Способы создания таблиц в AutoCAD

Способы создания таблиц в AutoCAD Автоматизация тестирования ДБО

Автоматизация тестирования ДБО Разработка тренажерно - обучающей системы для изучения иностранных языков

Разработка тренажерно - обучающей системы для изучения иностранных языков