Содержание

- 2. Содержание Неблокирующие коллективные операции Общее описание Передача данных Операции сокращения данных Разделение и сбор данных Всеобщие

- 3. Неблокирующие коллективные операции Расширения MPI Н.Новгород, 2018 Передача данных Операции сокращения данных Разделение и сбор данных

- 4. Неблокирующие коллективные обмены… Общее описание Неблокирующие коллективные операции обладают потенциальными преимуществами неблокирующих двусторонних операций, а также

- 5. Неблокирующие коллективные обмены… Общее описание Окончание выполнения операции не означает, что другие процессы завершили или даже

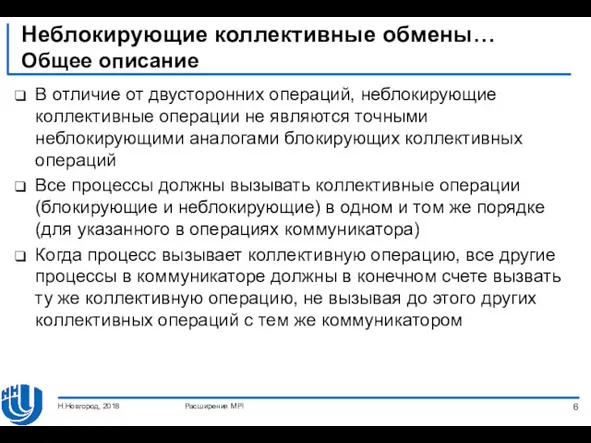

- 6. Неблокирующие коллективные обмены… Общее описание В отличие от двусторонних операций, неблокирующие коллективные операции не являются точными

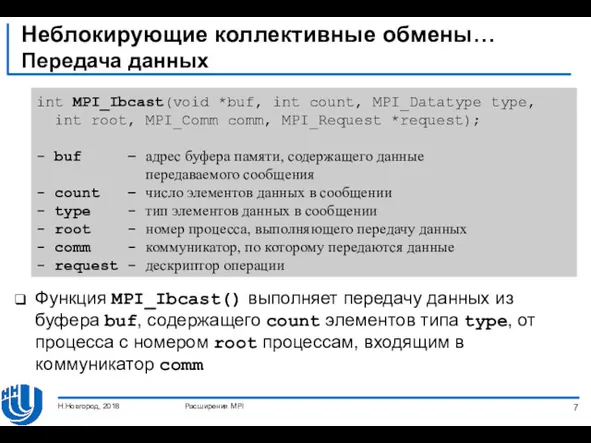

- 7. Неблокирующие коллективные обмены… Передача данных Функция MPI_Ibcast() выполняет передачу данных из буфера buf, содержащего count элементов

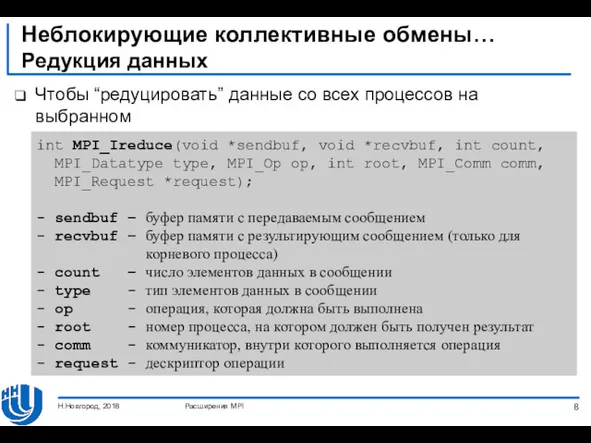

- 8. Неблокирующие коллективные обмены… Редукция данных Чтобы “редуцировать” данные со всех процессов на выбранном Н.Новгород, 2018 Расширения

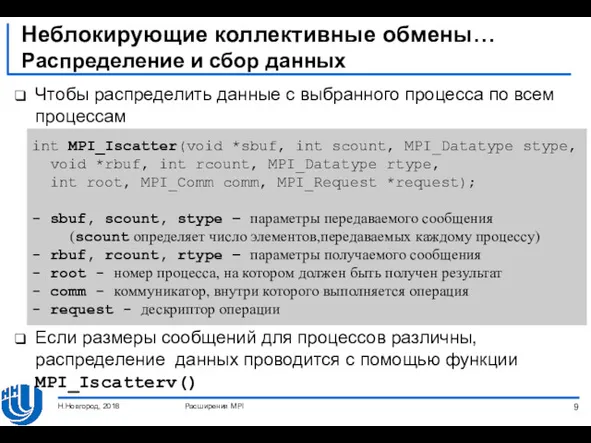

- 9. Неблокирующие коллективные обмены… Распределение и сбор данных Чтобы распределить данные с выбранного процесса по всем процессам

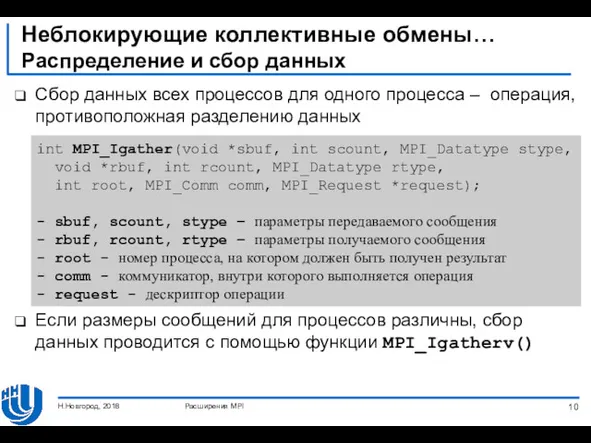

- 10. Неблокирующие коллективные обмены… Распределение и сбор данных Сбор данных всех процессов для одного процесса – операция,

- 11. Неблокирующие коллективные обмены… Всеобщие обмены Чтобы получить все собранные данные на каждом процессе коммуникатора, необходимо использовать

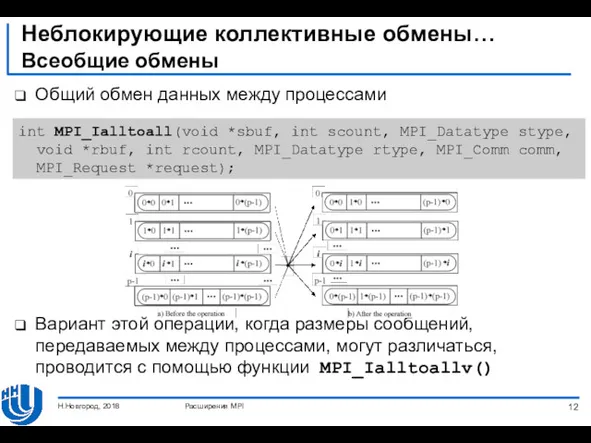

- 12. Неблокирующие коллективные обмены… Всеобщие обмены Общий обмен данных между процессами Вариант этой операции, когда размеры сообщений,

- 13. Неблокирующие коллективные обмены… Всеобщие обмены Чтобы получить результаты редукции данных на каждом процессе коммуникатора, необходимо использовать

- 14. Неблокирующие коллективные обмены Синхронизация вычислений MPI_IBarrier() - неблокирующая версия MPI_Barrier() Вызывая MPI_IBarrier(), процесс объявляет, что он

- 15. Создание и управление процессами Расширения MPI Н.Новгород, 2018 Общее описание Динамическая модель процессов Управление процессами Установка

- 16. Создание и управление процессами Общее описание Важные классы приложений MPI, которым требуется контроль над процессами ферма

- 17. Создание и управление процессами… Динамическая модель процессов Динамическая модель процессов делает возможным создание и совместное завершение

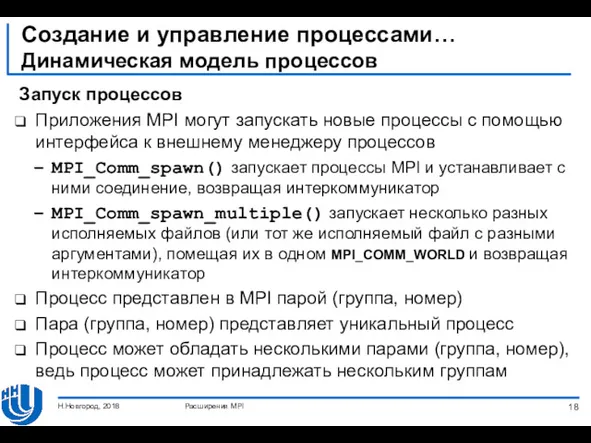

- 18. Создание и управление процессами… Динамическая модель процессов Запуск процессов Приложения MPI могут запускать новые процессы с

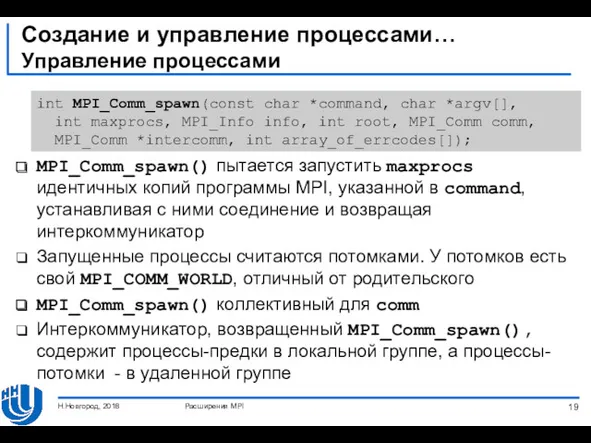

- 19. Создание и управление процессами… Управление процессами MPI_Comm_spawn() пытается запустить maxprocs идентичных копий программы MPI, указанной в

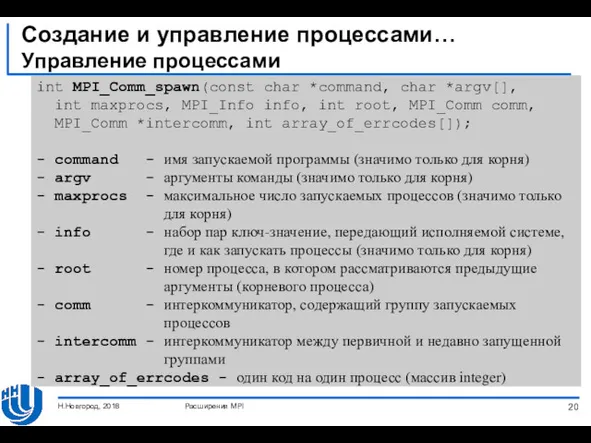

- 20. Создание и управление процессами… Управление процессами Расширения MPI Н.Новгород, 2018 int MPI_Comm_spawn(const char *command, char *argv[],

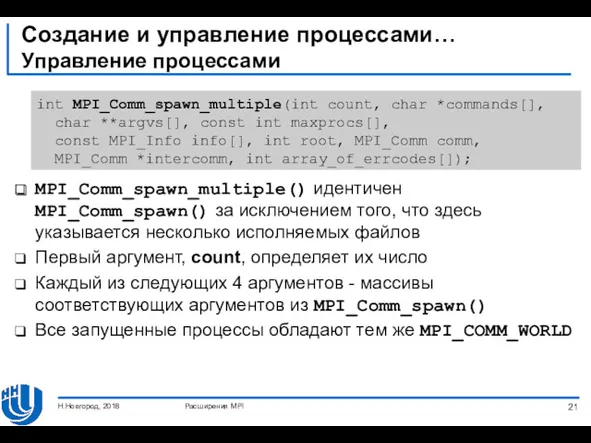

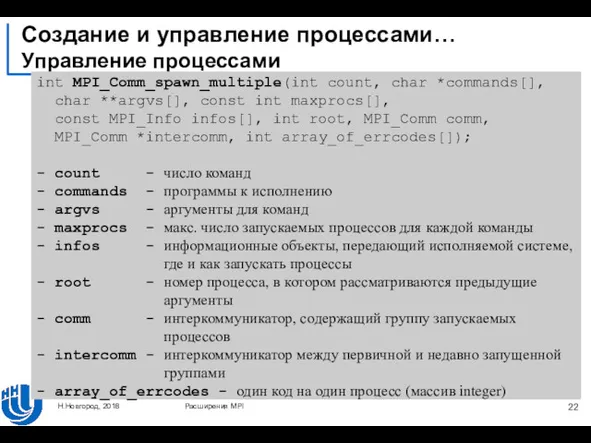

- 21. Создание и управление процессами… Управление процессами MPI_Comm_spawn_multiple() идентичен MPI_Comm_spawn() за исключением того, что здесь указывается несколько

- 22. Создание и управление процессами… Управление процессами Расширения MPI Н.Новгород, 2018 int MPI_Comm_spawn_multiple(int count, char *commands[], char

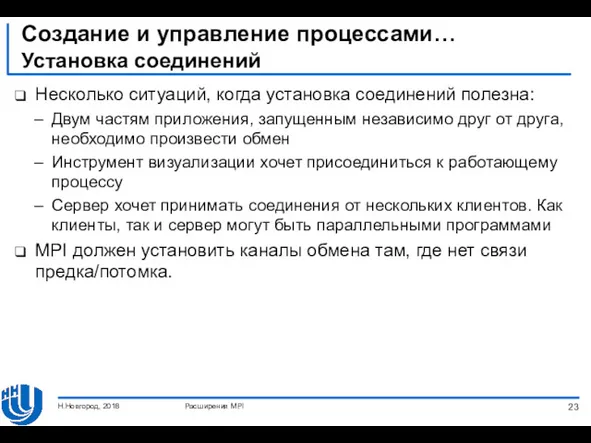

- 23. Создание и управление процессами… Установка соединений Несколько ситуаций, когда установка соединений полезна: Двум частям приложения, запущенным

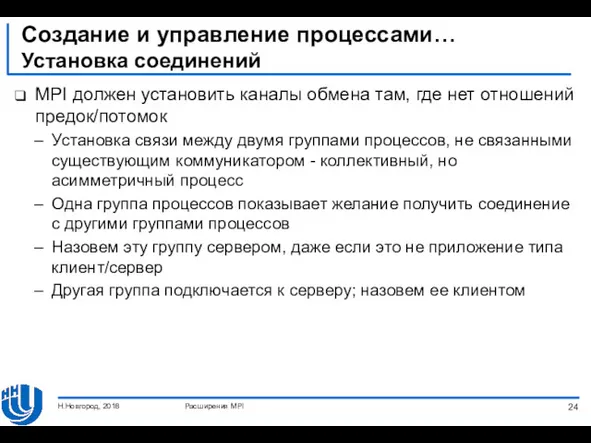

- 24. Создание и управление процессами… Установка соединений MPI должен установить каналы обмена там, где нет отношений предок/потомок

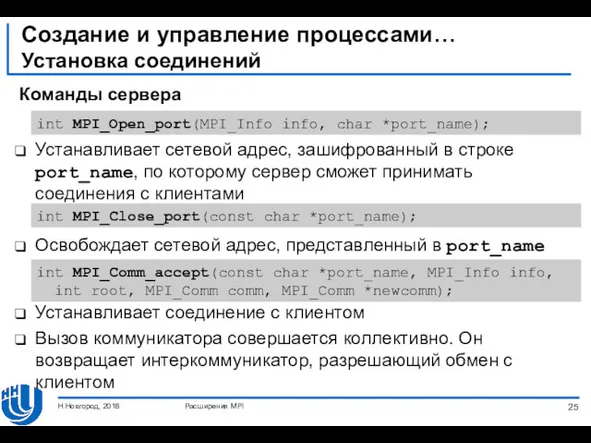

- 25. Создание и управление процессами… Установка соединений Команды сервера Устанавливает сетевой адрес, зашифрованный в строке port_name, по

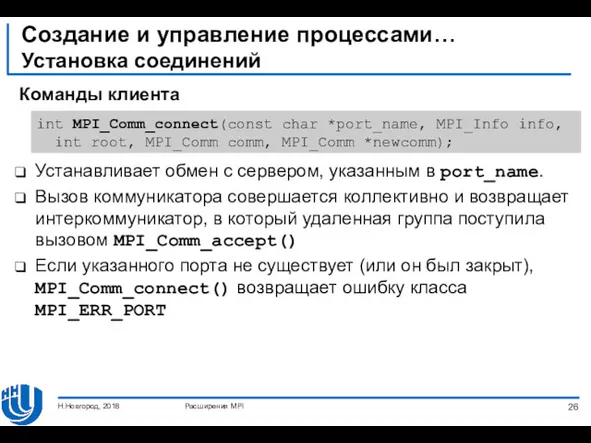

- 26. Создание и управление процессами… Установка соединений Команды клиента Устанавливает обмен с сервером, указанным в port_name. Вызов

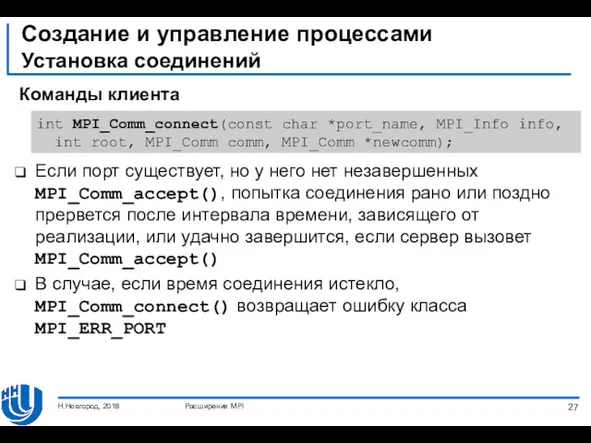

- 27. Создание и управление процессами Установка соединений Команды клиента Если порт существует, но у него нет незавершенных

- 28. Заключение Обсудили неблокирующие коллективные операции Создание и управление дополнительными процессами в программе MPI рассмотрены Н.Новгород, 2018

- 29. Упражнения Разработайте тестовую программу для каждого метода неблокирующих коллективных операций Разработайте тестовую программу, используя дополнительные процессы

- 31. Скачать презентацию

Прикладные компьютерные программы в обработке социологических данных. Вводная лекция

Прикладные компьютерные программы в обработке социологических данных. Вводная лекция Exercise session 1

Exercise session 1 Основы алгоритмизации и программирования

Основы алгоритмизации и программирования Объектно-ориентированное программирование. Унифицированный язык моделирования UML

Объектно-ориентированное программирование. Унифицированный язык моделирования UML Техника безопасности во время каникул.

Техника безопасности во время каникул. Программирование разветвляющихся алгоритмов. Условный оператор. Составной оператор. Многообразие способов записи ветвления

Программирование разветвляющихся алгоритмов. Условный оператор. Составной оператор. Многообразие способов записи ветвления Modeling and Solving Constraints. Basic Idea

Modeling and Solving Constraints. Basic Idea Системное программное обеспечение. Операционная система. (Лекция 6.1)

Системное программное обеспечение. Операционная система. (Лекция 6.1) Законы распределения и их применение для расчетов и анализа

Законы распределения и их применение для расчетов и анализа BI manager BI-система, бизнес аналитика

BI manager BI-система, бизнес аналитика Malicious code

Malicious code Создание ОФП в Microstation

Создание ОФП в Microstation Программирование линейных алгоритмов. Начала программирования. 8 класс

Программирование линейных алгоритмов. Начала программирования. 8 класс Основные понятия криптографической защиты. Симметричные алгоритмы шифрования

Основные понятия криптографической защиты. Симметричные алгоритмы шифрования Modbus Plus

Modbus Plus Использование различных сервисов для визуализации учебного материала

Использование различных сервисов для визуализации учебного материала Новые печатные формы диплома и приложения к диплому с формированием QR кода в 1С:Колледж и 1С:Колледж ПРОФ

Новые печатные формы диплома и приложения к диплому с формированием QR кода в 1С:Колледж и 1С:Колледж ПРОФ Электронные ресурсы для науки и образования. Тенденции развития библиотечно-информационного обслуживания

Электронные ресурсы для науки и образования. Тенденции развития библиотечно-информационного обслуживания Архиваторы. Архивация данных. (1 курс)

Архиваторы. Архивация данных. (1 курс) Операциондық жүйе

Операциондық жүйе Метод прямого выбора SelectSort

Метод прямого выбора SelectSort Общие сведения о языке программирования python начала программирования

Общие сведения о языке программирования python начала программирования кл. Создание текстовых документов на компьютере

кл. Создание текстовых документов на компьютере Системы оптического распознавания документов

Системы оптического распознавания документов 2. Java Basics. Data Types

2. Java Basics. Data Types Понятие информационной системы (ИС). Классификация ИС

Понятие информационной системы (ИС). Классификация ИС Ақпараттық қауіпсіздікті қамтамасыз ету комплексті тәсілі. Ақпараттық қауіпсіздік негізгі ұғымдары

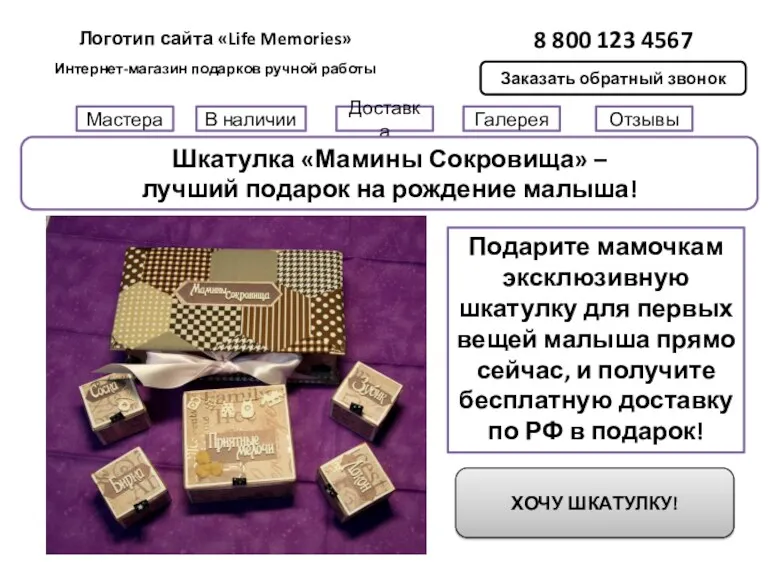

Ақпараттық қауіпсіздікті қамтамасыз ету комплексті тәсілі. Ақпараттық қауіпсіздік негізгі ұғымдары Интернет-магазин подарков ручной работы

Интернет-магазин подарков ручной работы