Содержание

- 2. Принцип самообучения Самообучение сети заключается в подстройке весов синапсов на основании информации содержащейся в поданном входном

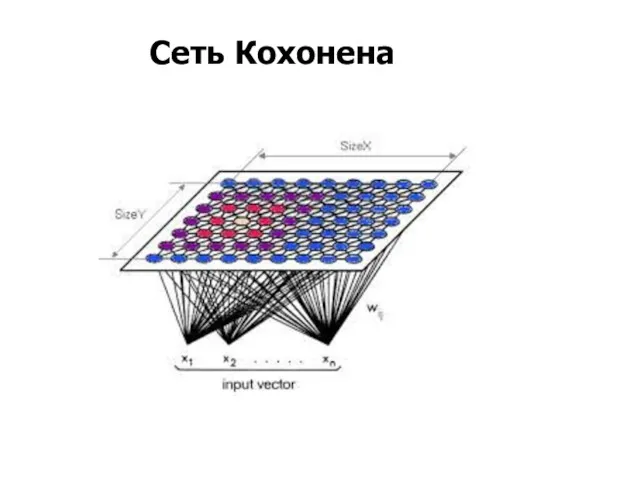

- 3. Сеть Кохонена

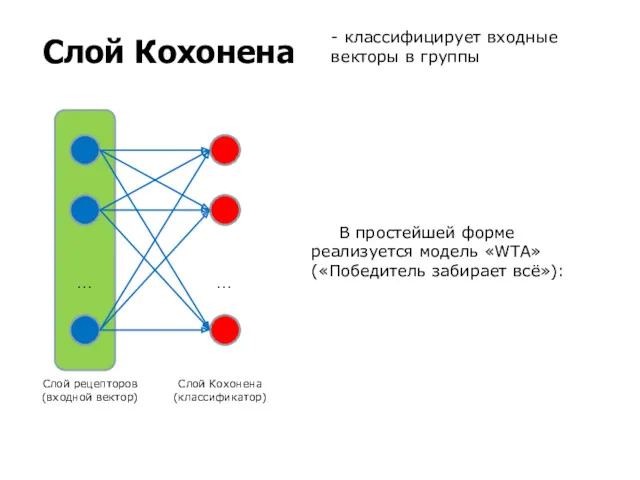

- 4. Слой Кохонена Слой рецепторов (входной вектор) Слой Кохонена (классификатор) … … - классифицирует входные векторы в

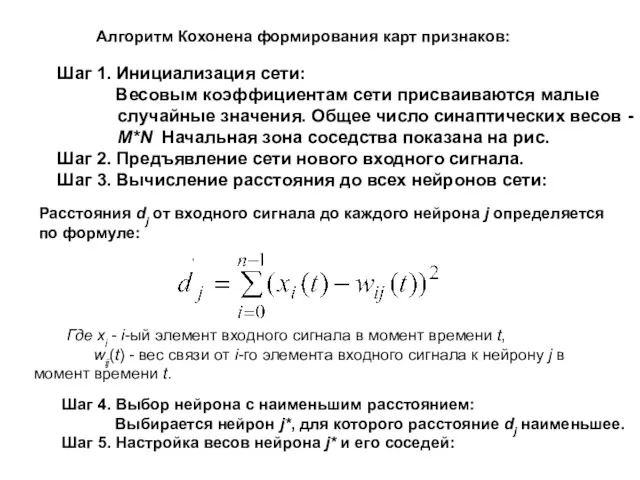

- 5. Алгоритм Кохонена формирования карт признаков: , Шаг 1. Инициализация сети: Весовым коэффициентам сети присваиваются малые случайные

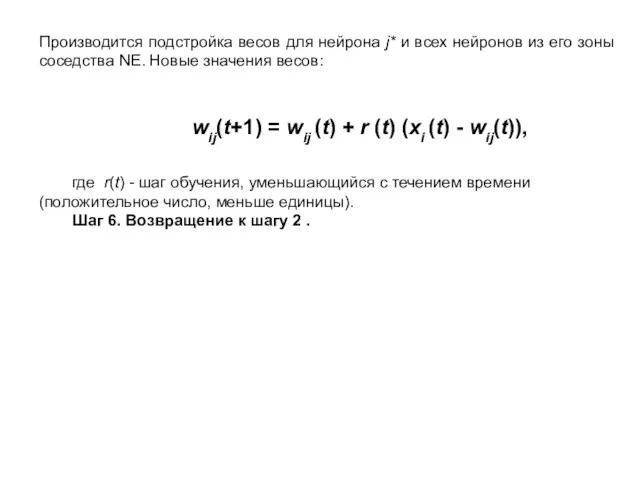

- 6. Производится подстройка весов для нейрона j* и всех нейронов из его зоны соседства NE. Новые значения

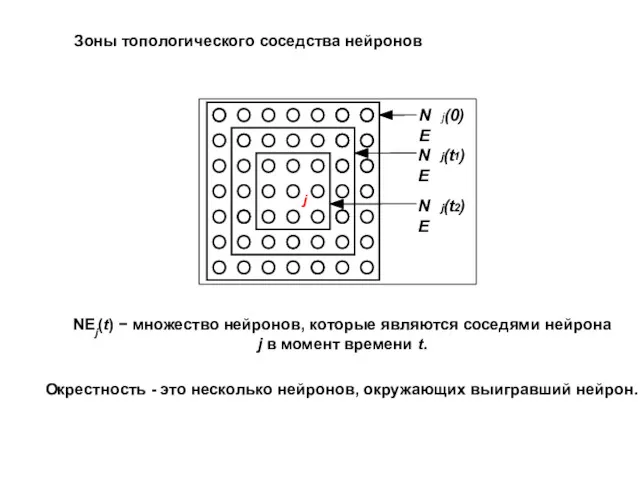

- 7. Зоны топологического соседства нейронов j NE j (0) NE j (t 1 ) NE j (t

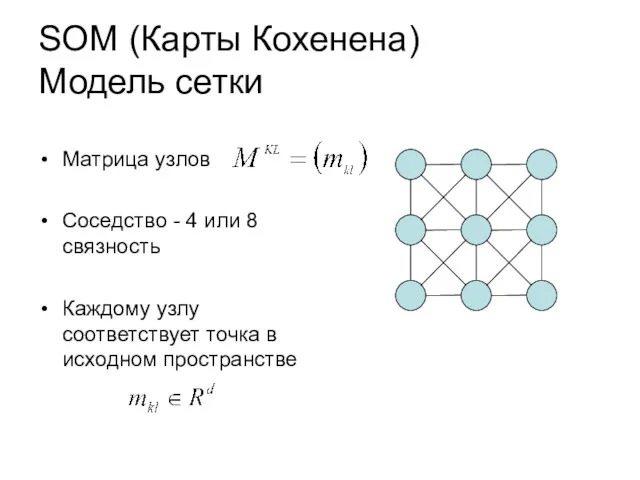

- 8. SOM (Карты Кохенена) Модель сетки Матрица узлов Соседство - 4 или 8 связность Каждому узлу соответствует

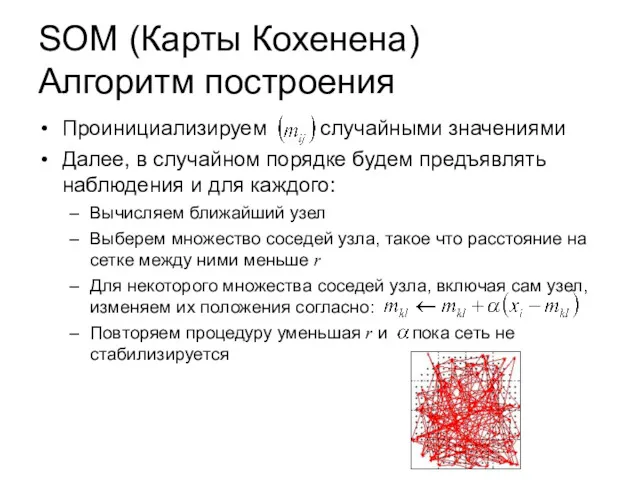

- 9. SOM (Карты Кохенена) Алгоритм построения Проинициализируем случайными значениями Далее, в случайном порядке будем предъявлять наблюдения и

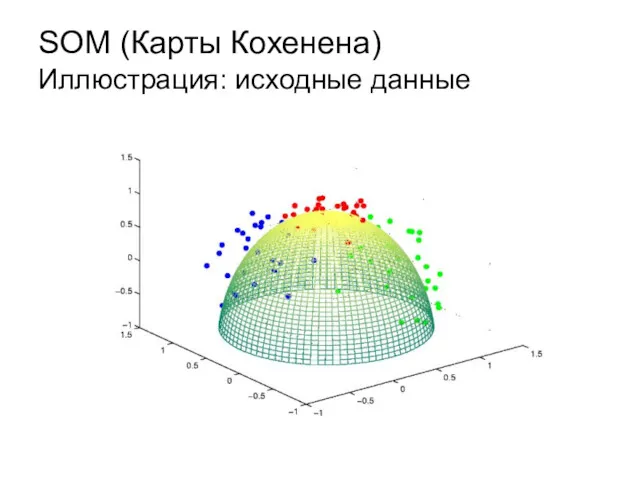

- 10. SOM (Карты Кохенена) Иллюстрация: исходные данные

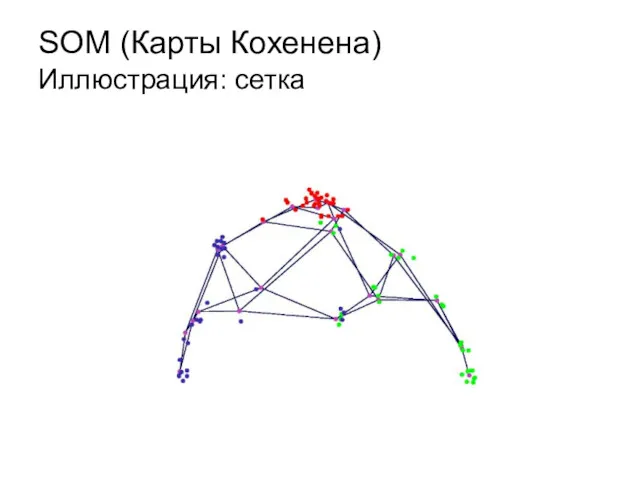

- 11. SOM (Карты Кохенена) Иллюстрация: сетка

- 12. SOM (Карты Кохенена) Иллюстрация: проекции на матрицу

- 13. Интерпретация работы слоя Кохонена Вид откликов на каждый класс входных образов не известен заранее и будет

- 14. SOM (Карты Кохенена) Практическое использование Данные представляют некоторую поверхность, требуется сократить размерность Хорошо подходят для последующей

- 15. Монохромные (бинарные) изображения 2 цвета (черный и белый) Изображение представляется в виде растра (таблицы) со значениями

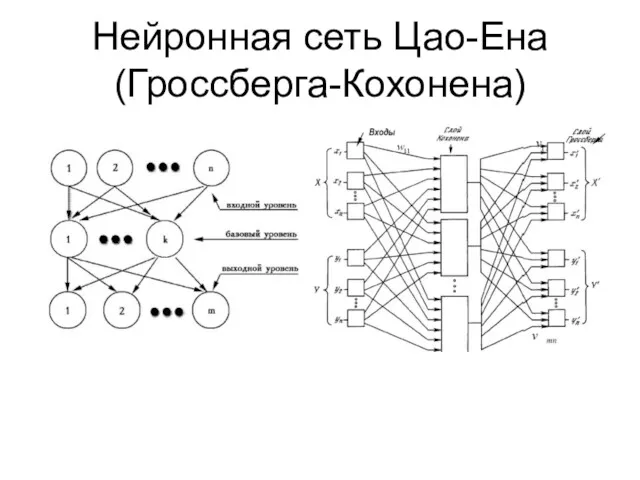

- 16. Нейронная сеть Цао-Ена (Гроссберга-Кохонена) Количество входов: размер обучаемого сегмента изображения (16=4x4) Количество выходов: размер выходного сегмента

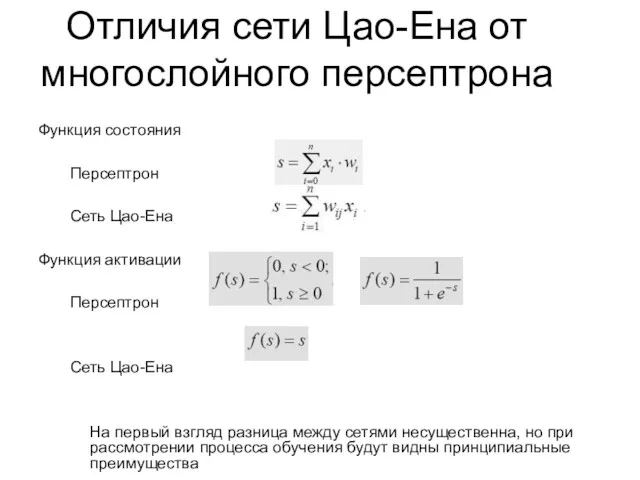

- 17. Отличия сети Цао-Ена от многослойного персептрона Функция состояния Персептрон Сеть Цао-Ена Функция активации Персептрон Сеть Цао-Ена

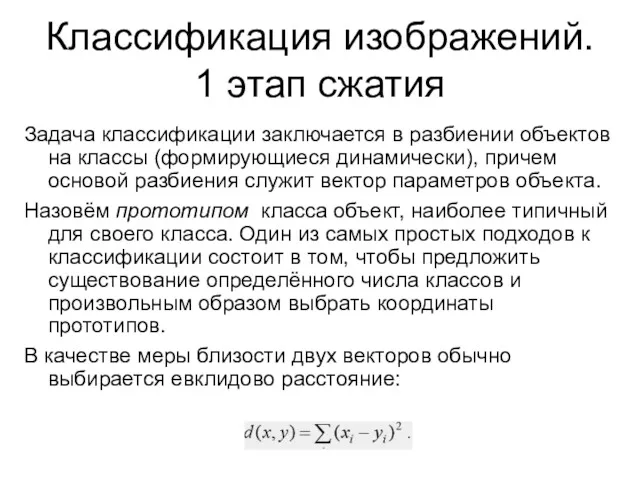

- 18. Классификация изображений. 1 этап сжатия Задача классификации заключается в разбиении объектов на классы (формирующиеся динамически), причем

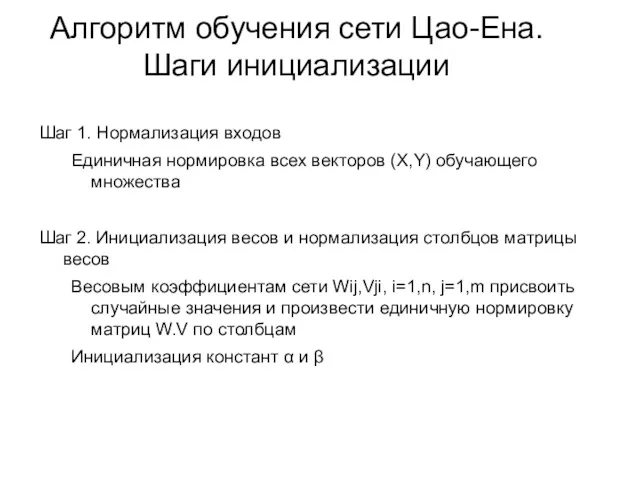

- 19. Алгоритм обучения сети Цао-Ена. Шаги инициализации Шаг 1. Нормализация входов Единичная нормировка всех векторов (X,Y) обучающего

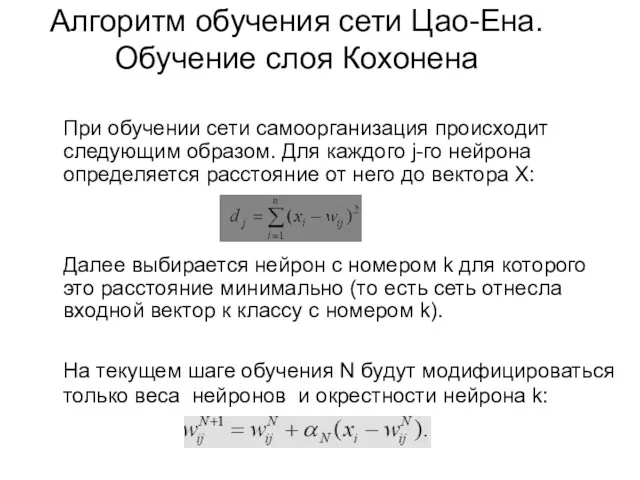

- 20. Алгоритм обучения сети Цао-Ена. Обучение слоя Кохонена При обучении сети самоорганизация происходит следующим образом. Для каждого

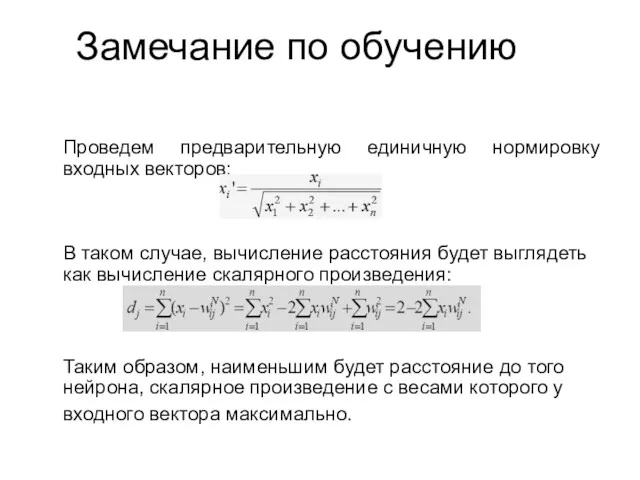

- 21. Замечание по обучению Проведем предварительную единичную нормировку входных векторов: В таком случае, вычисление расстояния будет выглядеть

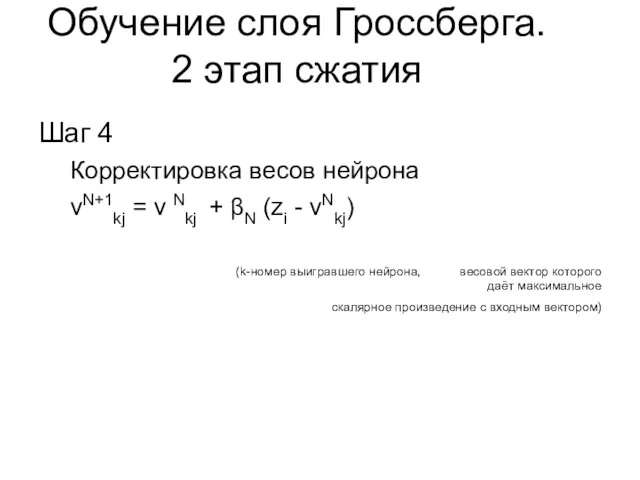

- 22. Обучение слоя Гроссберга. 2 этап сжатия Шаг 4 Корректировка весов нейрона vN+1kj = v Nkj +

- 23. Алгоритм обучения сети Цао-Ена. Итерации Шаг 5 Уменьшение значений αN, βN Шаг 6 Повтор шагов 3-5

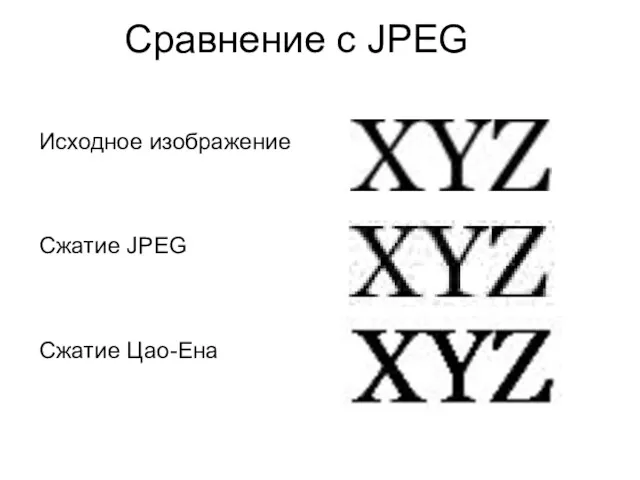

- 24. Сравнение с JPEG Исходное изображение Сжатие JPEG Сжатие Цао-Ена

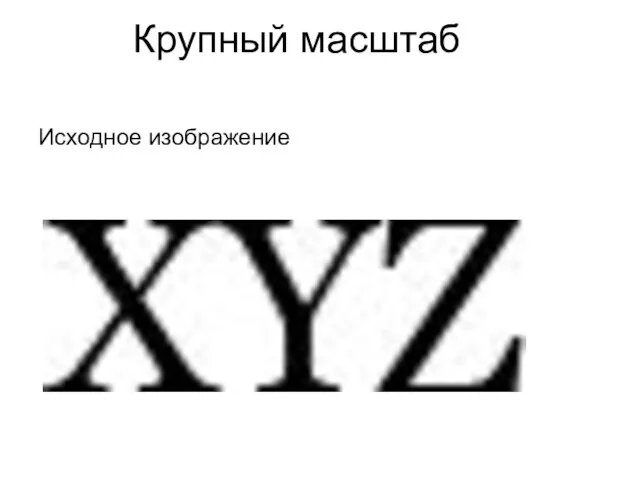

- 25. Крупный масштаб Исходное изображение

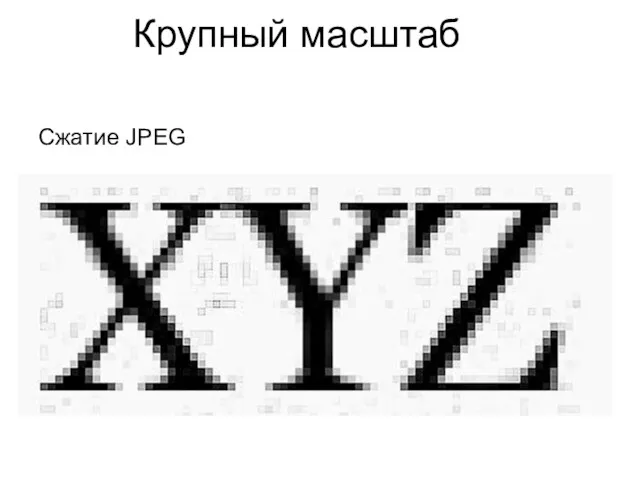

- 26. Крупный масштаб Сжатие JPEG

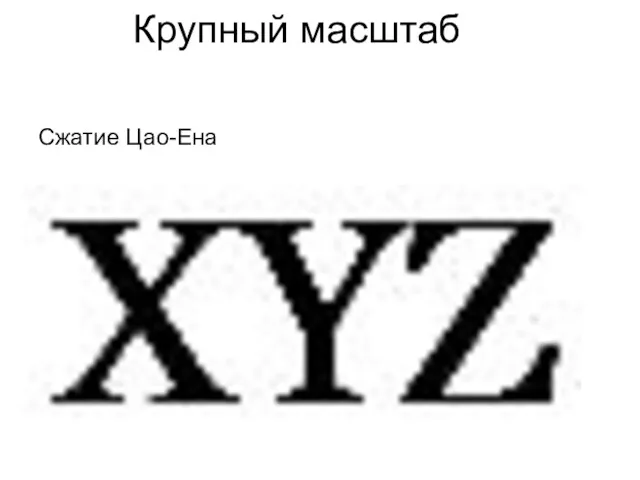

- 27. Крупный масштаб Сжатие Цао-Ена

- 29. Скачать презентацию

Создание эффективных презентаций

Создание эффективных презентаций Путешествие по клавишам

Путешествие по клавишам Презентация Техника безопасности в компьютерном кабинете у дошкольников

Презентация Техника безопасности в компьютерном кабинете у дошкольников Логические и поразрядные операции

Логические и поразрядные операции Сплайны - работа с элементами объектов. Autodesk 3ds max. Лекция №2

Сплайны - работа с элементами объектов. Autodesk 3ds max. Лекция №2 Пользовательский интерфейс

Пользовательский интерфейс Создание мобильного приложения для пользователей ЖКХ

Создание мобильного приложения для пользователей ЖКХ Основы построения инфокоммуникационных систем и сетей

Основы построения инфокоммуникационных систем и сетей 11_Позиционирование

11_Позиционирование Правила безопасного интернета

Правила безопасного интернета Алгоритм управления и кибернетика

Алгоритм управления и кибернетика Блочные алгоритмы. Блочное шифрование. Сравнение блочных и поточных шифров. Предпосылки создания шифра Фейстеля

Блочные алгоритмы. Блочное шифрование. Сравнение блочных и поточных шифров. Предпосылки создания шифра Фейстеля Visual Studio 2008. Overview

Visual Studio 2008. Overview Учебные исполнители, как примеры формальных исполнителей

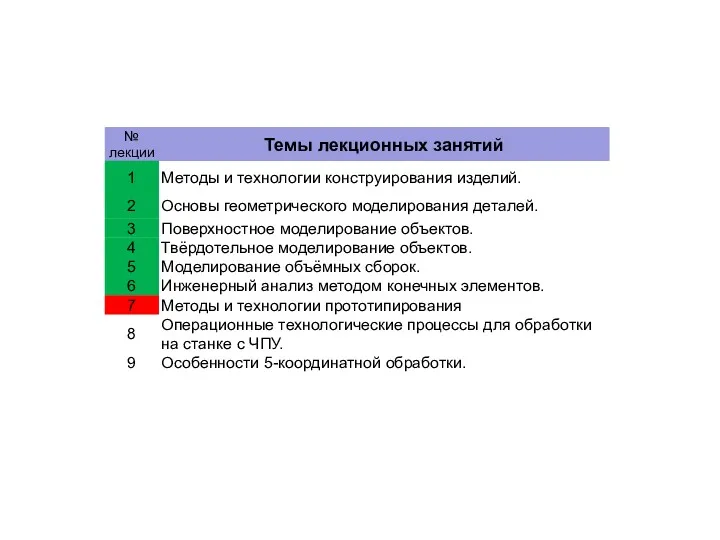

Учебные исполнители, как примеры формальных исполнителей Методы и технологии прототипирования изделий. (Лекция 7)

Методы и технологии прототипирования изделий. (Лекция 7) Технология создания текстовых документов

Технология создания текстовых документов Учебный центр. Общее о справочнике. Сервис 2ГИС

Учебный центр. Общее о справочнике. Сервис 2ГИС Кодирование информации

Кодирование информации Навыки. Пользователи

Навыки. Пользователи Цифровые карты. Цифровые модели местности

Цифровые карты. Цифровые модели местности Документальные информационные системы

Документальные информационные системы Веб-сайты. Тест

Веб-сайты. Тест Скоростное прохождение игр

Скоростное прохождение игр Интеллектуальные информационные системы управления. Лекция 5

Интеллектуальные информационные системы управления. Лекция 5 Web Attacks: cross-site request forgery, SQL injection, cross-site scripting

Web Attacks: cross-site request forgery, SQL injection, cross-site scripting Прикладной интерфейс для разработчика

Прикладной интерфейс для разработчика Работа с электронными таблицами в программе Microsoft Excel

Работа с электронными таблицами в программе Microsoft Excel Методология IDEF0

Методология IDEF0