Слайд 2

План лекции

Ограничения линейных моделей

Модель глубокого обучения

Вычислительные возможности нейросетей

Слои моделей

Функция активации

Обратное распространение

ошибки

Реализации функции активации

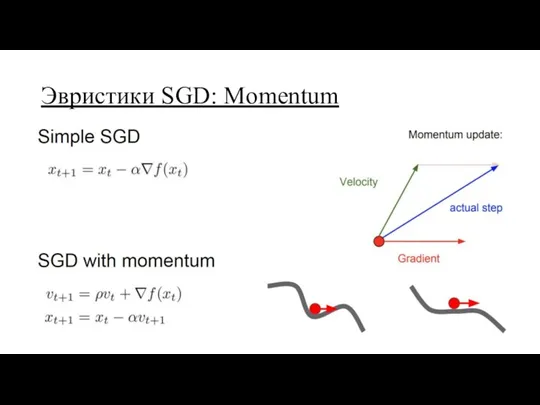

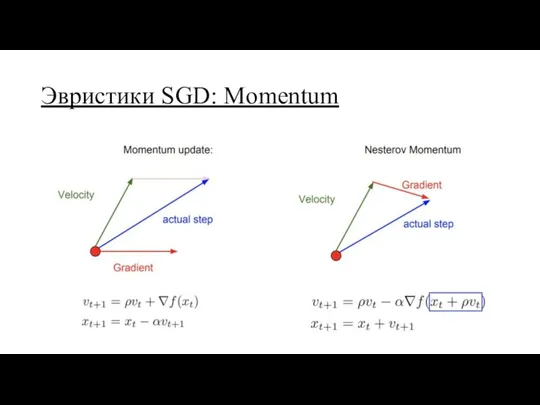

Эвристики стохастического градиентного спуска

Нормировка признаков

Регуляризация (прореживание)

Слайд 3

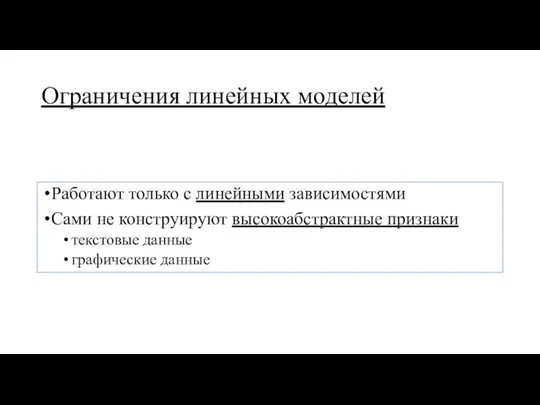

Ограничения линейных моделей

Работают только с линейными зависимостями

Сами не конструируют высокоабстрактные признаки

текстовые

данные

графические данные

Слайд 4

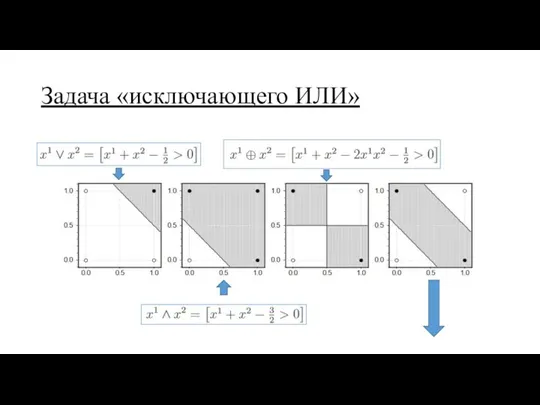

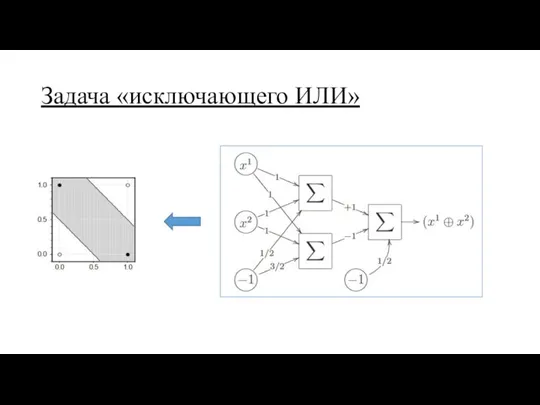

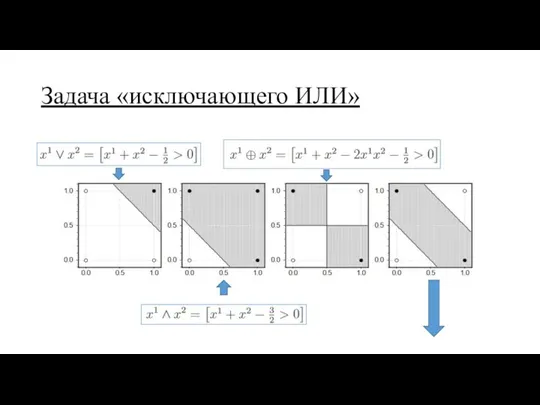

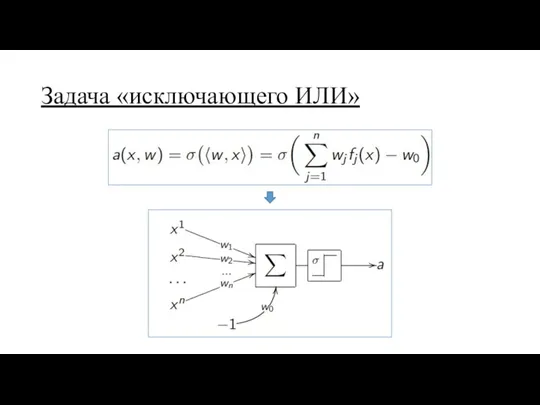

Задача «исключающего ИЛИ»

Слайд 5

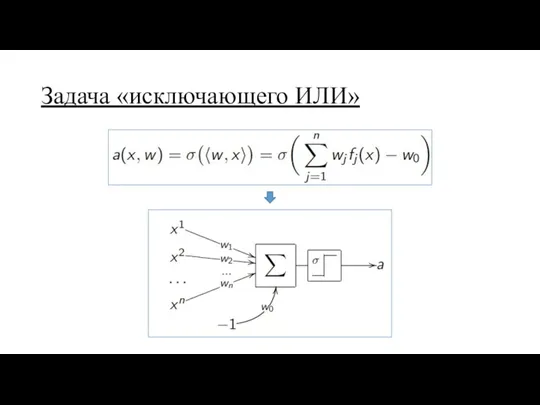

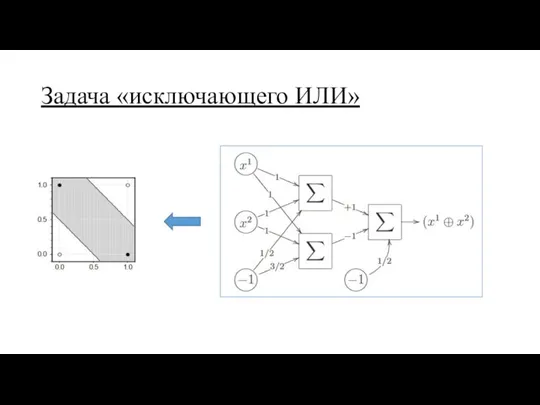

Задача «исключающего ИЛИ»

Слайд 6

Задача «исключающего ИЛИ»

Слайд 7

Задача «исключающего ИЛИ»

Слайд 8

Задача «исключающего ИЛИ»

Таким образом два решения:

конструирование нового признака на основе исходных

(сложно)

построение композиции моделей

Слайд 9

Слайд 10

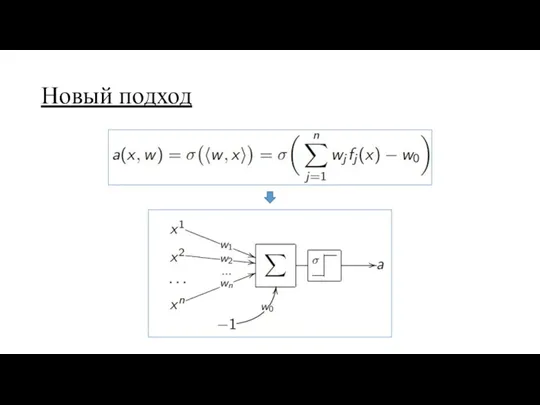

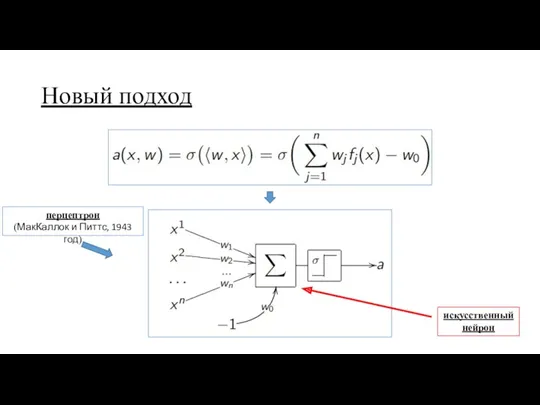

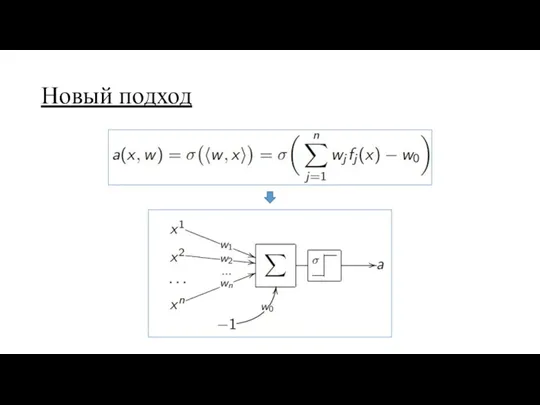

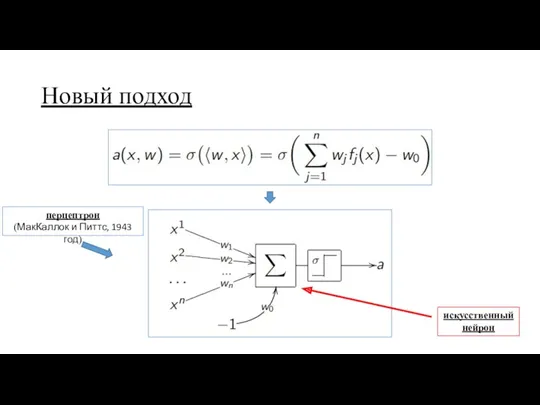

Новый подход

перцептрон

(МакКаллок и Питтс, 1943 год)

искусственный

нейрон

Слайд 11

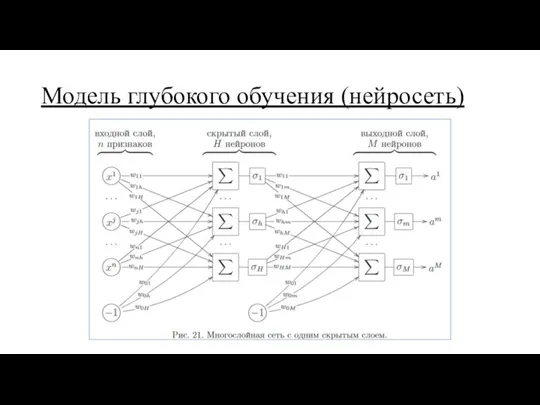

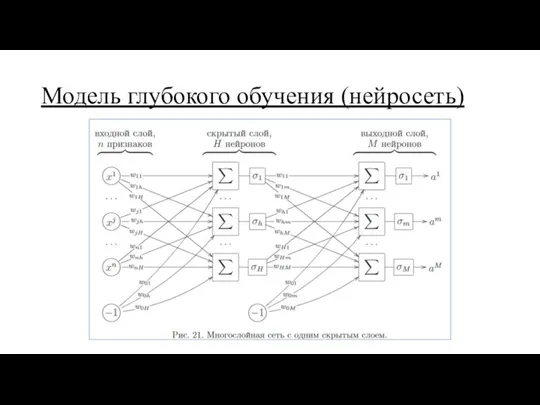

Модель глубокого обучения (нейросеть)

Слайд 12

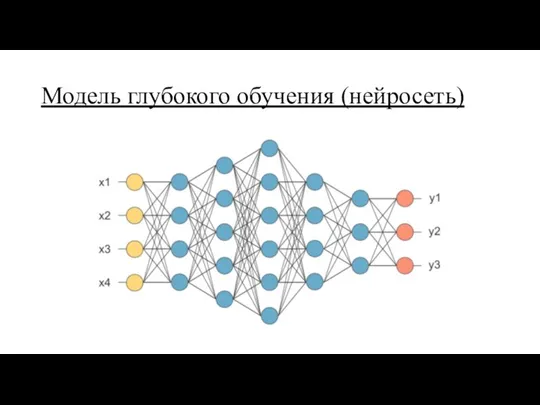

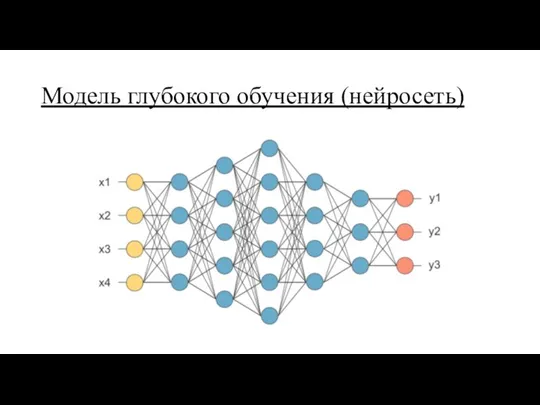

Модель глубокого обучения (нейросеть)

Слайд 13

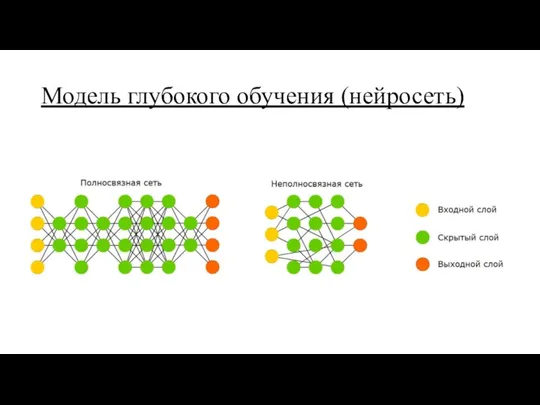

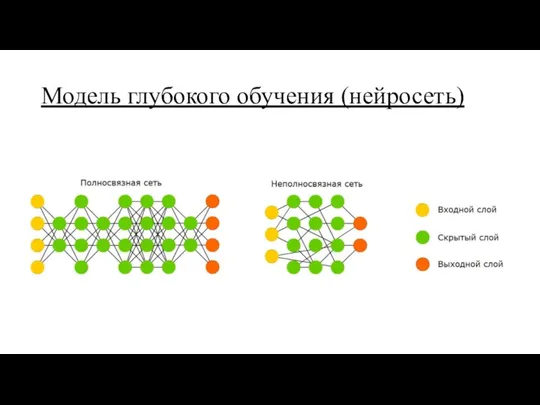

Модель глубокого обучения (нейросеть)

Слайд 14

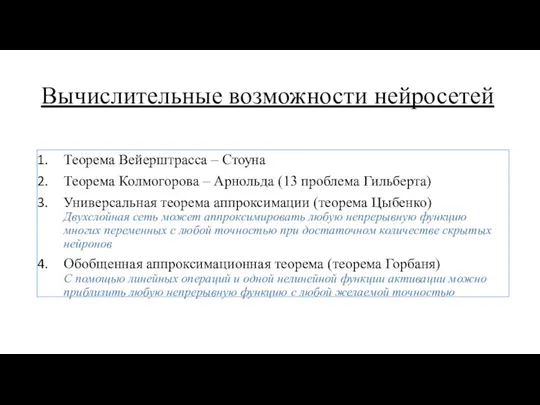

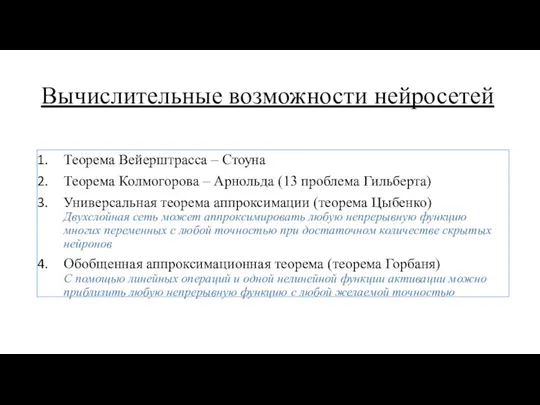

Вычислительные возможности нейросетей

Теорема Вейерштрасса – Стоуна

Теорема Колмогорова – Арнольда (13 проблема

Гильберта)

Универсальная теорема аппроксимации (теорема Цыбенко)

Двухслойная сеть может аппроксимировать любую непрерывную функцию многих переменных с любой точностью при достаточном количестве скрытых нейронов

Обобщенная аппроксимационная теорема (теорема Горбаня)

С помощью линейных операций и одной нелинейной функции активации можно приблизить любую непрерывную функцию с любой желаемой точностью

Слайд 15

Вычислительные возможности нейросетей

Несколько замечаний:

двух слоёв достаточно для аппроксимации практически всех «математических»

функций

нейросети обучаются преобразованию признаков

глубина сети позволяет распознавать и конструировать высокоабстрактные признаки

Слайд 16

Слайд 17

Слайд 18

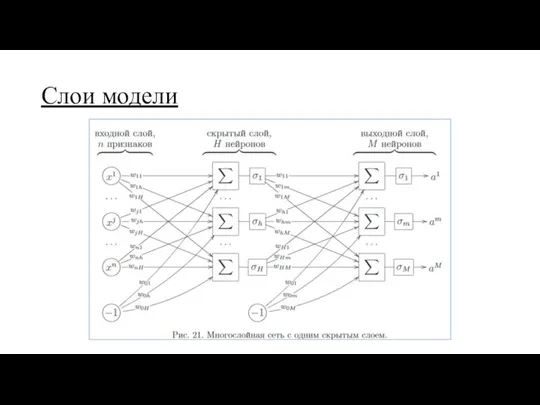

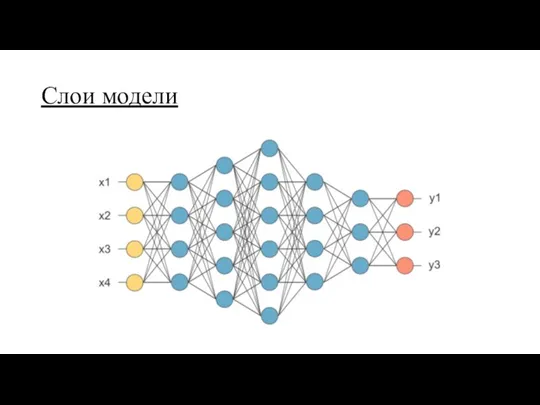

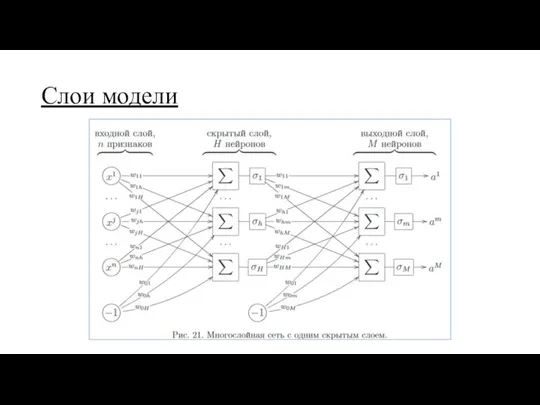

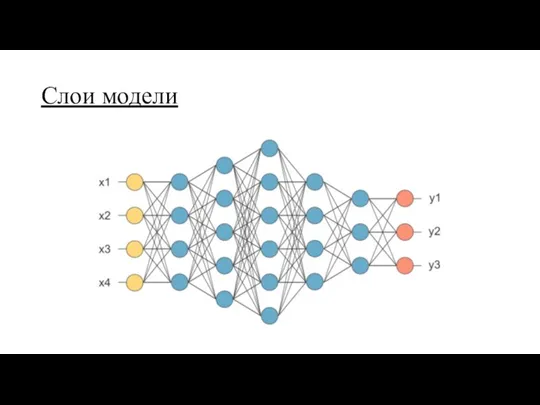

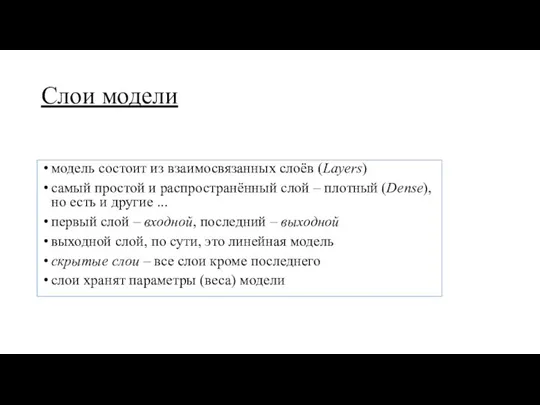

Слои модели

модель состоит из взаимосвязанных слоёв (Layers)

самый простой и распространённый слой

– плотный (Dense),

но есть и другие ...

первый слой – входной, последний – выходной

выходной слой, по сути, это линейная модель

скрытые слои – все слои кроме последнего

слои хранят параметры (веса) модели

Слайд 19

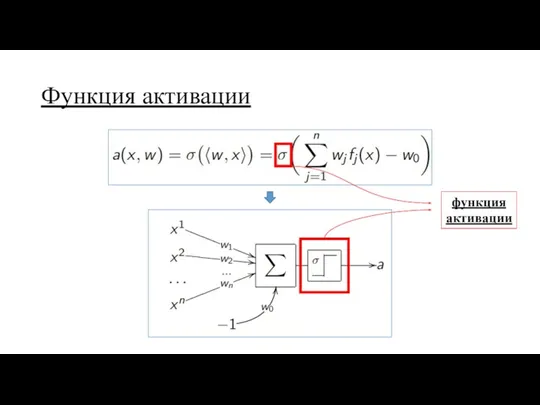

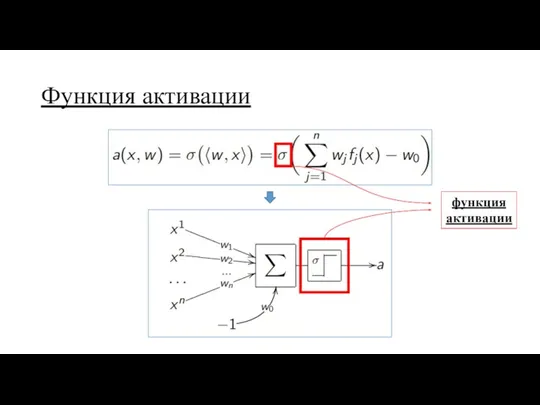

Функция активации

функция

активации

Слайд 20

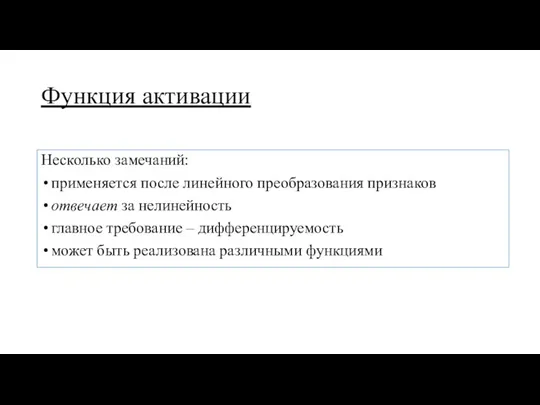

Функция активации

Несколько замечаний:

применяется после линейного преобразования признаков

отвечает за нелинейность

главное требование –

дифференцируемость

может быть реализована различными функциями

Слайд 21

Слайд 22

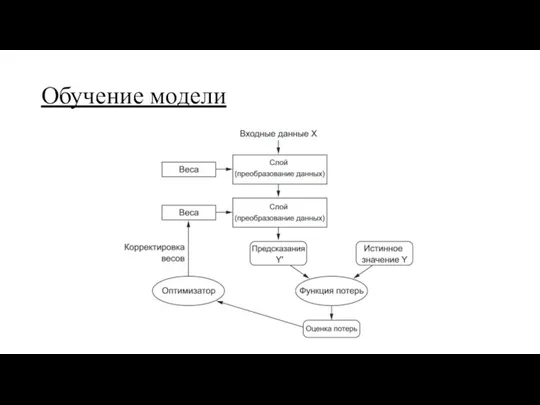

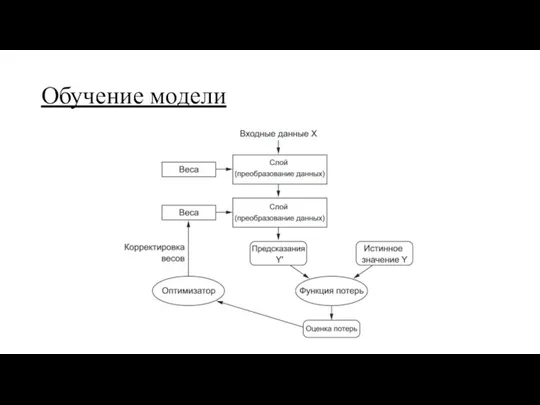

Обучение модели

Напоминание:

функция потерь численно определяет, на сколько решена задача

оптимизатор корректирует параметры

модели в сторону оптимальных

у линейных моделей оптимизатор использовал метод SGD

Слайд 23

Обучение модели

Каким методом будем обучать нейросеть?

Стохастическим градиентным спуском

Слайд 24

Обратное распространение ошибки

Он же:

backpropagation

цепное правило

производная сложной функции

Слайд 25

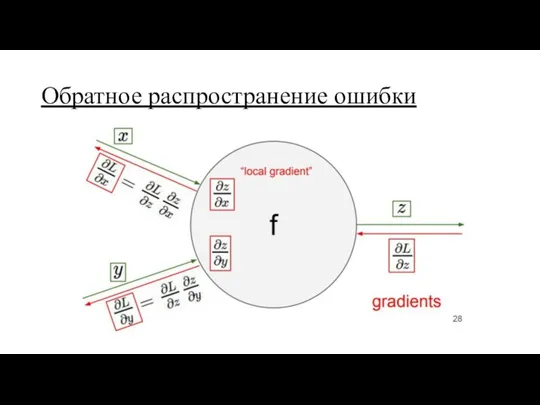

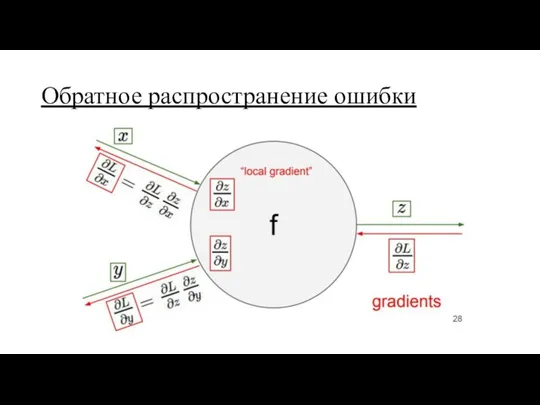

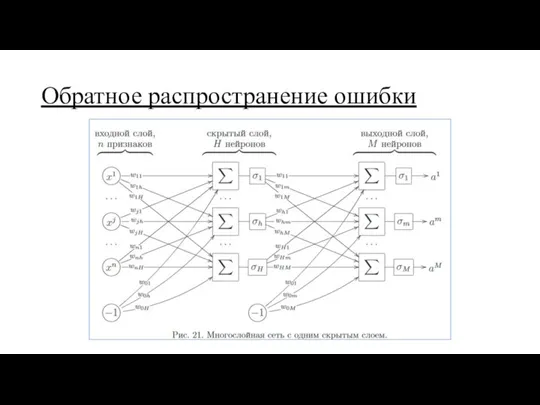

Обратное распространение ошибки

Слайд 26

Обратное распространение ошибки

Слайд 27

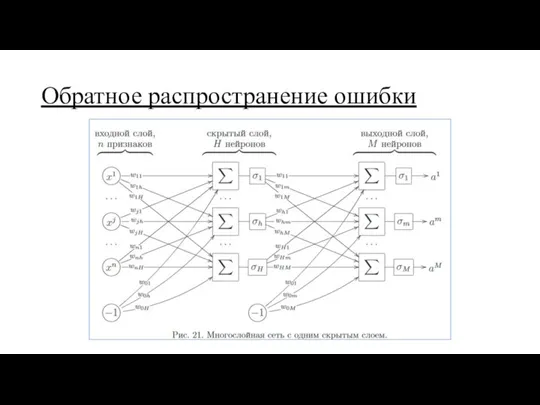

Алгоритм обратного распространения ошибки

Слайд 28

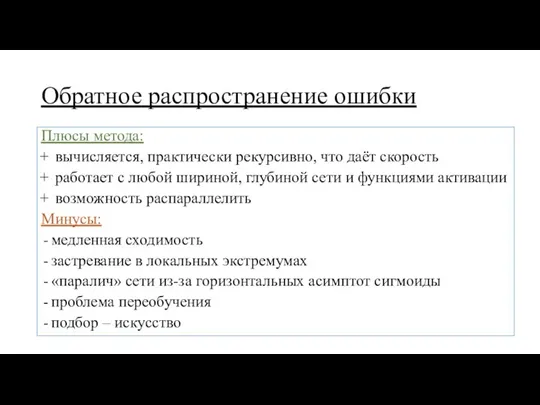

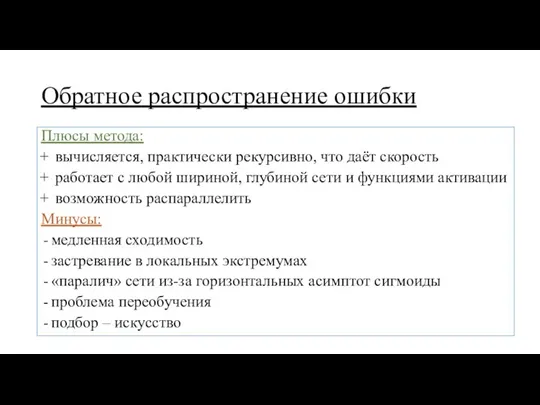

Обратное распространение ошибки

Плюсы метода:

вычисляется, практически рекурсивно, что даёт скорость

работает

с любой шириной, глубиной сети и функциями активации

возможность распараллелить

Минусы:

медленная сходимость

застревание в локальных экстремумах

«паралич» сети из-за горизонтальных асимптот сигмоиды

проблема переобучения

подбор – искусство

Слайд 29

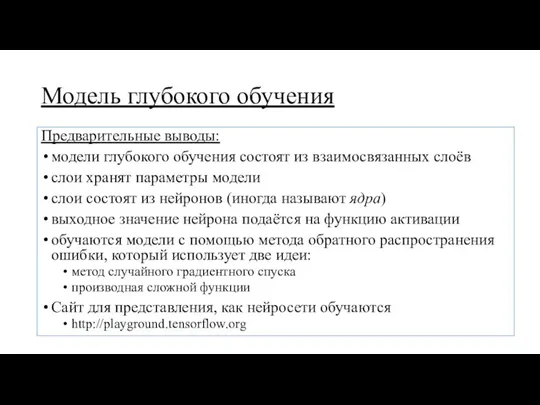

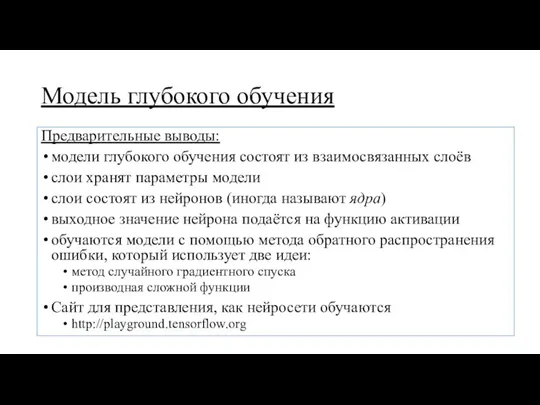

Модель глубокого обучения

Предварительные выводы:

модели глубокого обучения состоят из взаимосвязанных слоёв

слои хранят

параметры модели

слои состоят из нейронов (иногда называют ядра)

выходное значение нейрона подаётся на функцию активации

обучаются модели с помощью метода обратного распространения ошибки, который использует две идеи:

метод случайного градиентного спуска

производная сложной функции

Сайт для представления, как нейросети обучаются

http://playground.tensorflow.org

Слайд 30

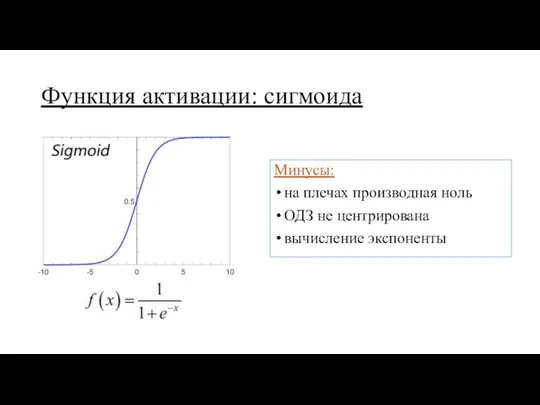

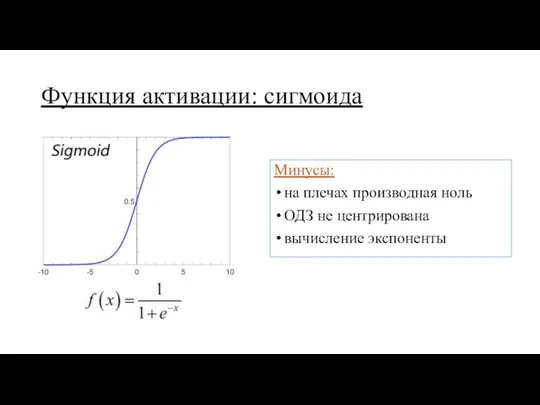

Функция активации: сигмоида

Минусы:

на плечах производная ноль

ОДЗ не центрирована

вычисление экспоненты

Слайд 31

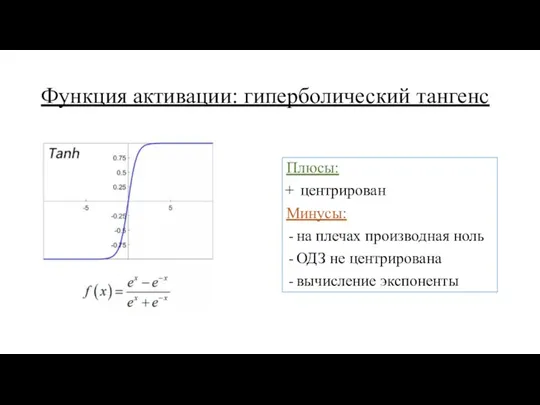

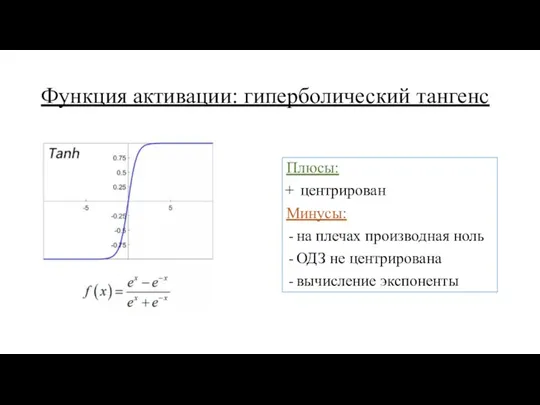

Функция активации: гиперболический тангенс

Плюсы:

центрирован

Минусы:

на плечах производная ноль

ОДЗ не центрирована

вычисление экспоненты

Слайд 32

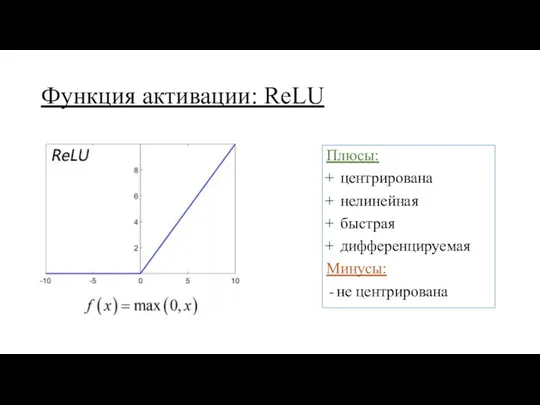

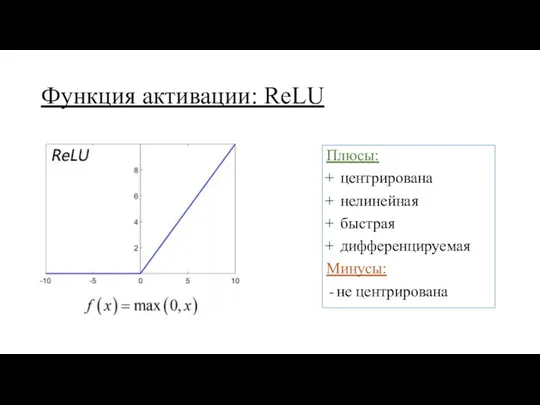

Функция активации: ReLU

Плюсы:

центрирована

нелинейная

быстрая

дифференцируемая

Минусы:

не центрирована

Слайд 33

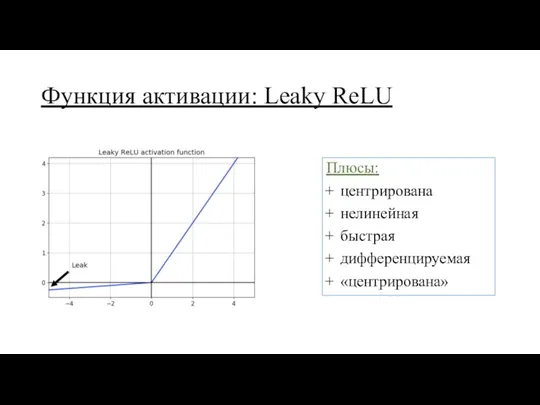

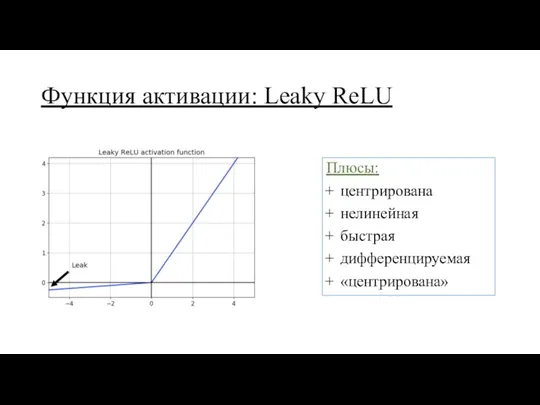

Функция активации: Leaky ReLU

Плюсы:

центрирована

нелинейная

быстрая

дифференцируемая

«центрирована»

Слайд 34

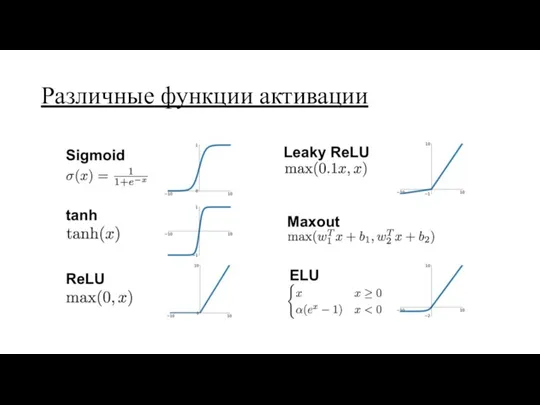

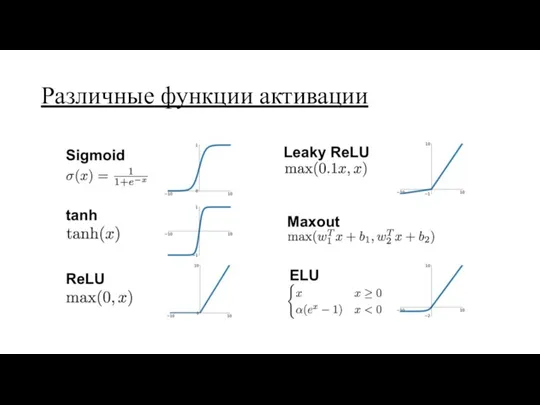

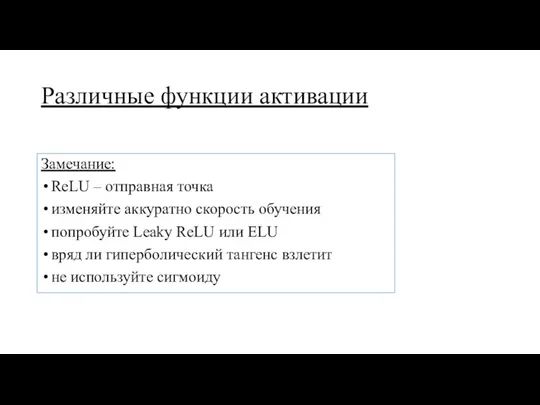

Различные функции активации

Слайд 35

Различные функции активации

Замечание:

ReLU – отправная точка

изменяйте аккуратно скорость обучения

попробуйте Leaky ReLU

или ELU

вряд ли гиперболический тангенс взлетит

не используйте сигмоиду

Слайд 36

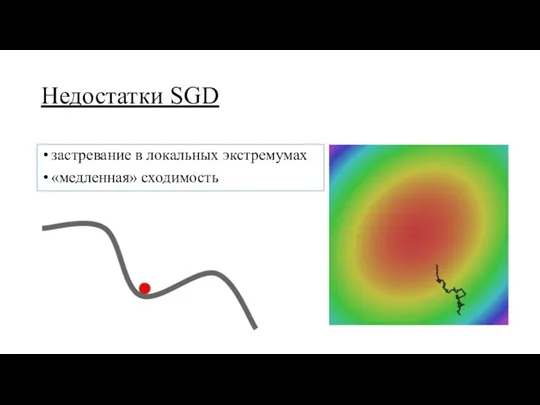

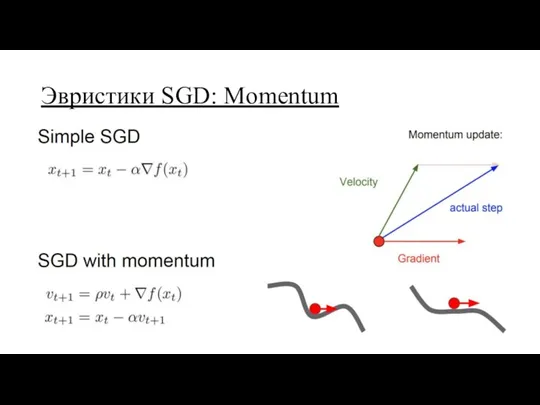

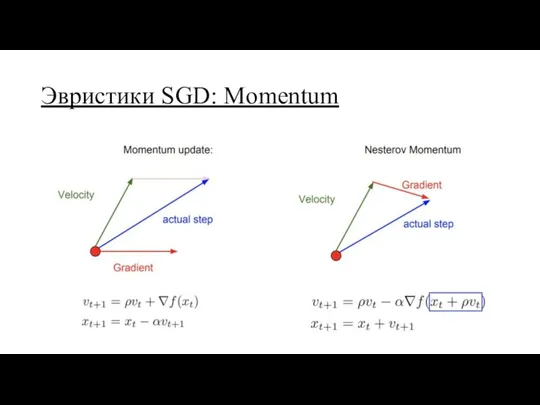

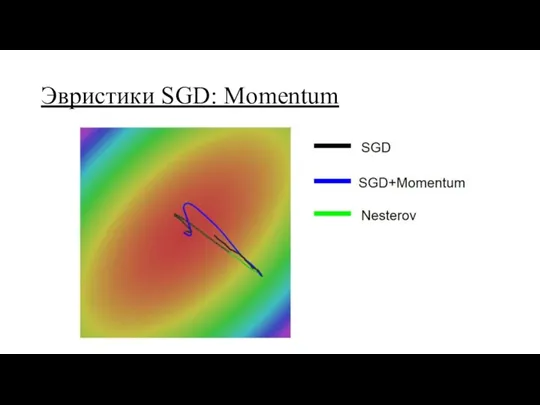

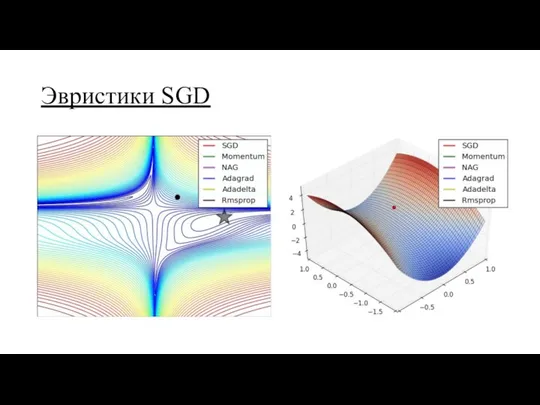

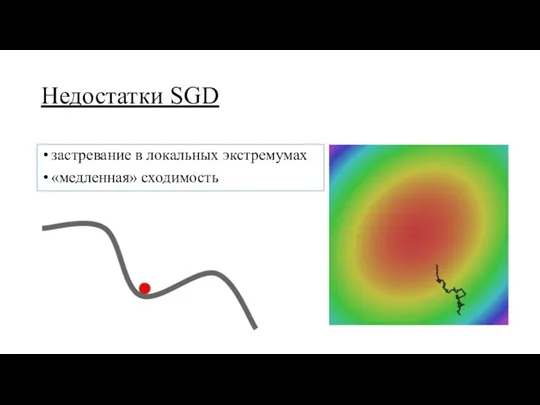

Недостатки SGD

застревание в локальных экстремумах

«медленная» сходимость

Слайд 37

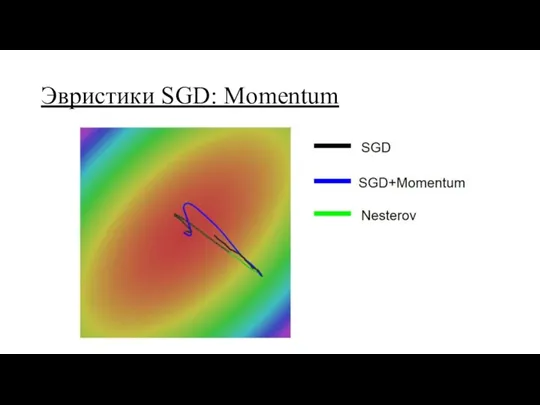

Слайд 38

Слайд 39

Слайд 40

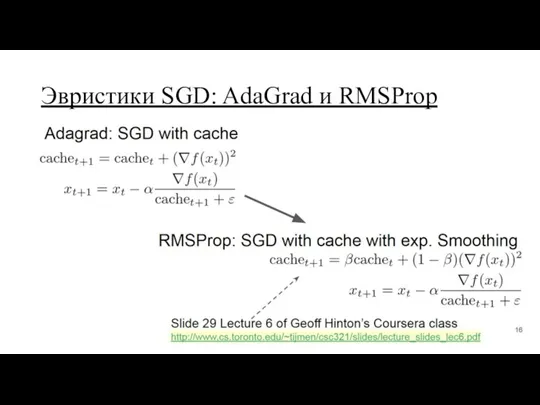

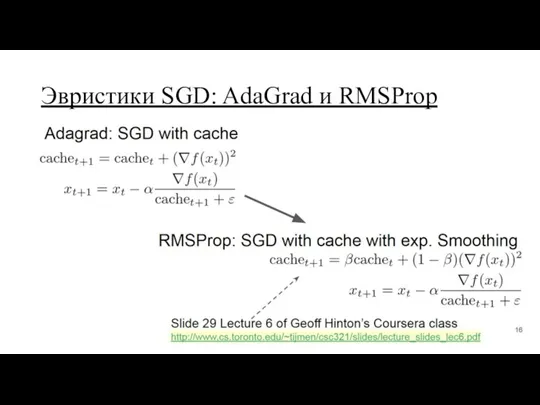

Эвристики SGD: AdaGrad и RMSProp

Слайд 41

Эвристики SGD: Adam

Включает в себя все перечисленные подходы

Слайд 42

Слайд 43

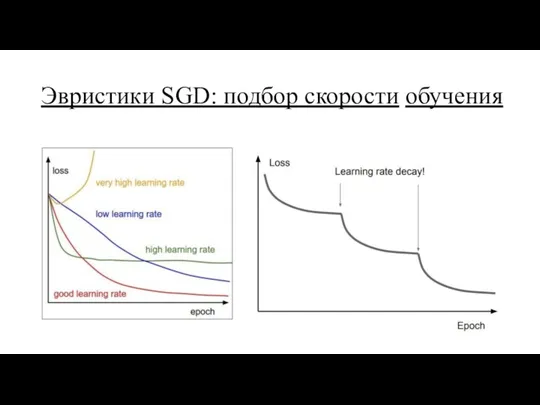

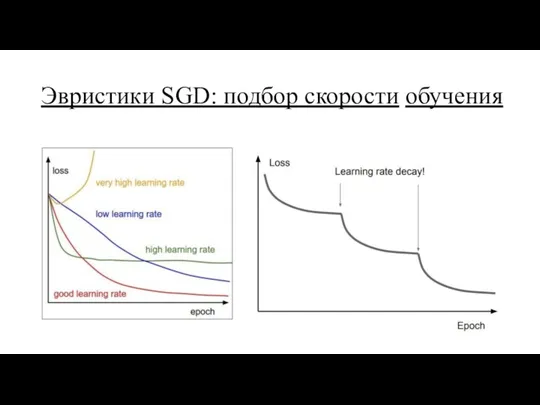

Эвристики SGD: подбор скорости обучения

Слайд 44

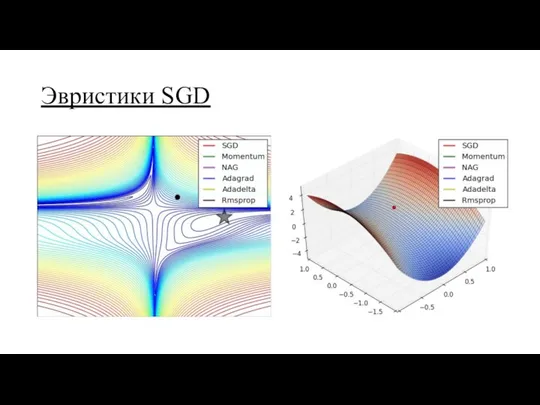

Эвристики SGD

Замечание:

чем навороченней эвристика, тем больше требуется памяти для хранения кэшей,

моментов и т.д.

тем не менее Adam – хороший выбор для начала

байка про Карпатого

уменьшайте скорость обучения по мере сходимости

динамически проверяйте качество

Слайд 45

Слайд 46

Слайд 47

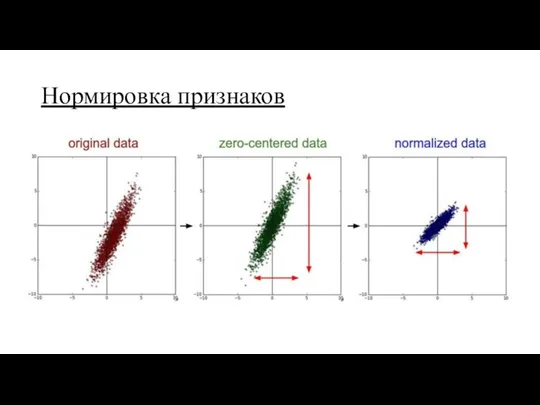

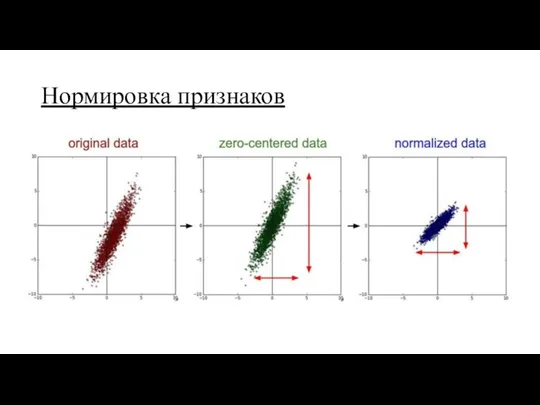

Нормировка признаков

Замечание:

модель, обученная на нормированных признаках, менее чувствительна к изменениям в

данных

градиентный спуск лучше сойдётся

Слайд 48

Слайд 49

Нормализация батча

Замечание:

позволяет решить проблему метода обратного распространения ошибки: параметры модели оптимизируются

«несогласовано»

намного ускоряет сходимость

позволяет увеличить скорость обучения

Слайд 50

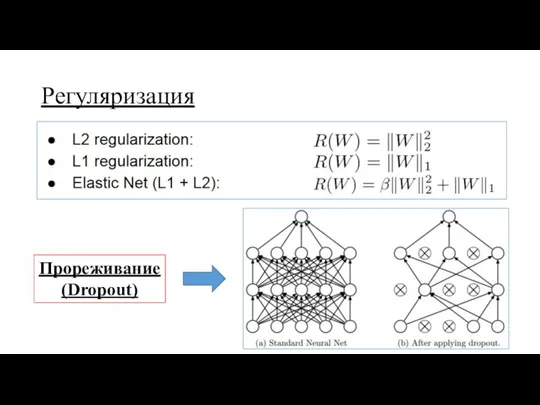

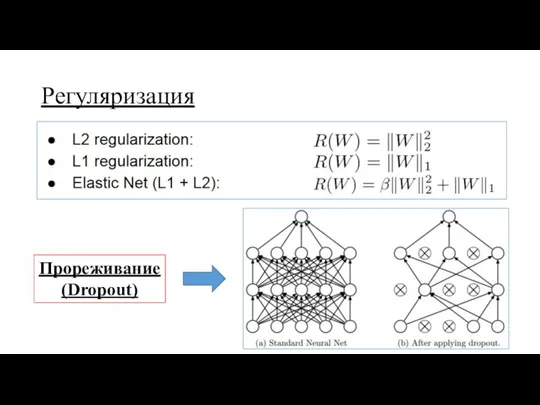

Регуляризация

Прореживание

(Dropout)

Слайд 51

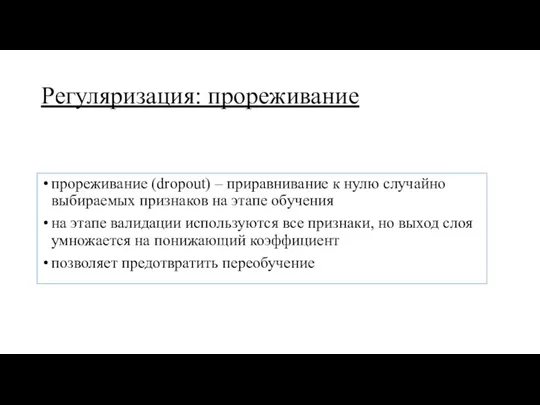

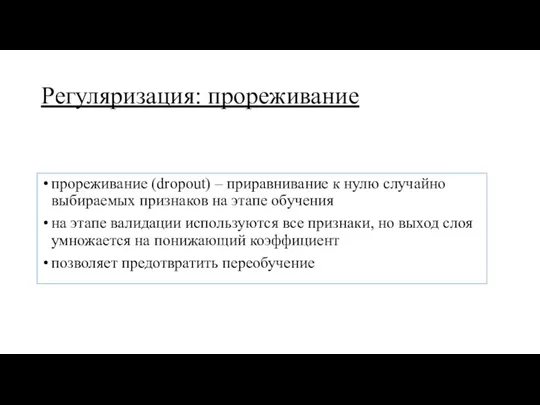

Регуляризация: прореживание

прореживание (dropout) – приравнивание к нулю случайно выбираемых признаков на

этапе обучения

на этапе валидации используются все признаки, но выход слоя умножается на понижающий коэффициент

позволяет предотвратить переобучение

Архитектура ОС MS Windows 2000+. Реестр

Архитектура ОС MS Windows 2000+. Реестр Электронные таблицы Excel

Электронные таблицы Excel История связи. Простейшие средства связи

История связи. Простейшие средства связи Растровая графика

Растровая графика مفاهيم دراسات المستفيدين من المعلومات

مفاهيم دراسات المستفيدين من المعلومات Компьютерные программные продукты для разработки бизнес-планов (Project Expert, COMFAR, Альт-Инвест, PROPSPIN)

Компьютерные программные продукты для разработки бизнес-планов (Project Expert, COMFAR, Альт-Инвест, PROPSPIN) Deep Web – теневой интернет

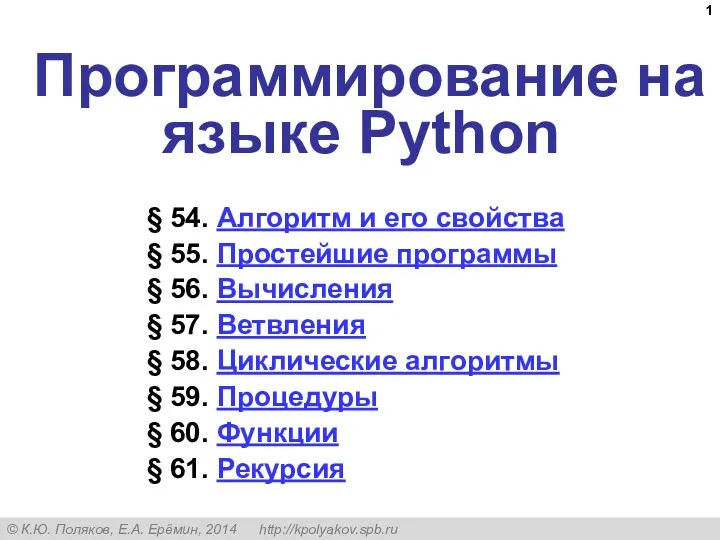

Deep Web – теневой интернет Программирование на Python

Программирование на Python Работа с диапазонами. Относительная адресация

Работа с диапазонами. Относительная адресация Определение количества информации

Определение количества информации Как создать компьютерный тест-пособие

Как создать компьютерный тест-пособие Система контроля устойчивости бортов. Преимущества выбора радаров MSR (reutech)

Система контроля устойчивости бортов. Преимущества выбора радаров MSR (reutech) Локальные компьютерные сети

Локальные компьютерные сети Создание базы адресов. Слияние

Создание базы адресов. Слияние Системы счисления

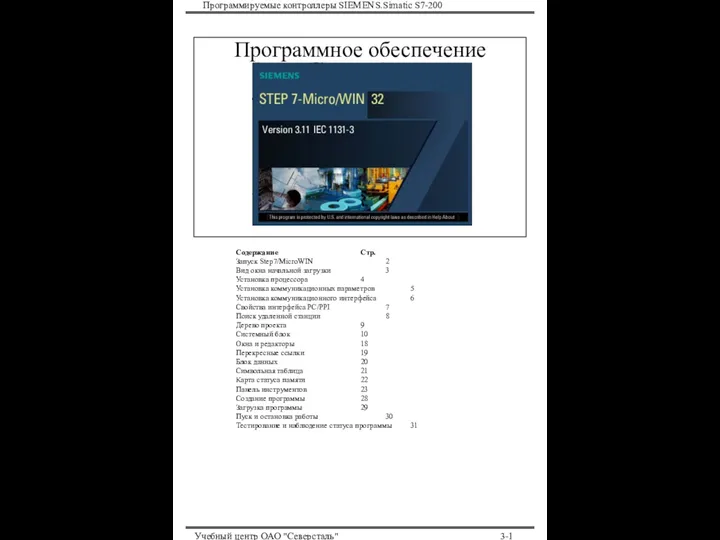

Системы счисления Программируемые контроллеры SIEMENS.Simatic S7-200. Программное обеспечение

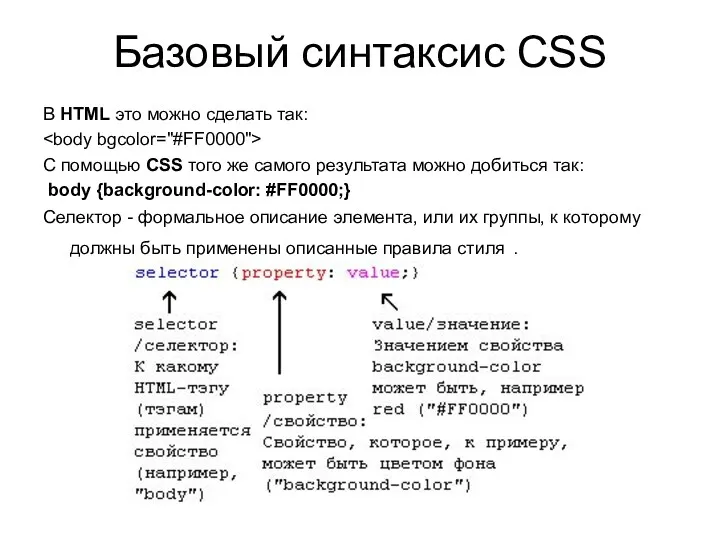

Программируемые контроллеры SIEMENS.Simatic S7-200. Программное обеспечение Базовый синтаксис CSS в HTML

Базовый синтаксис CSS в HTML Возрастной рейтинг игр

Возрастной рейтинг игр Программирование на языке Python. §54. Алгоритм и его свойства

Программирование на языке Python. §54. Алгоритм и его свойства Составление индивидуальной траектории обучения

Составление индивидуальной траектории обучения Основы синтаксиса. Операции в PHP

Основы синтаксиса. Операции в PHP Администрирование информационных систем. Серверы имен. DNS, WINS

Администрирование информационных систем. Серверы имен. DNS, WINS Урок

Урок Правила безопасного поведения в интернете для детей и подростков

Правила безопасного поведения в интернете для детей и подростков Ручные операции Партнерского Прайса

Ручные операции Партнерского Прайса Информационная культура. Основные понятия

Информационная культура. Основные понятия Урок по информатике в 9 классе на тему Мир электронной почты, телеконференция.

Урок по информатике в 9 классе на тему Мир электронной почты, телеконференция. Функції в Microsoft Excel

Функції в Microsoft Excel