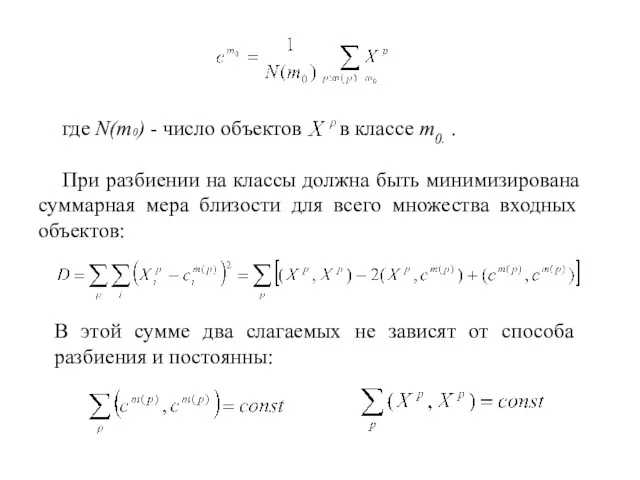

Если для решения задач классификации применять нейронные сети, то необходимо формализовать

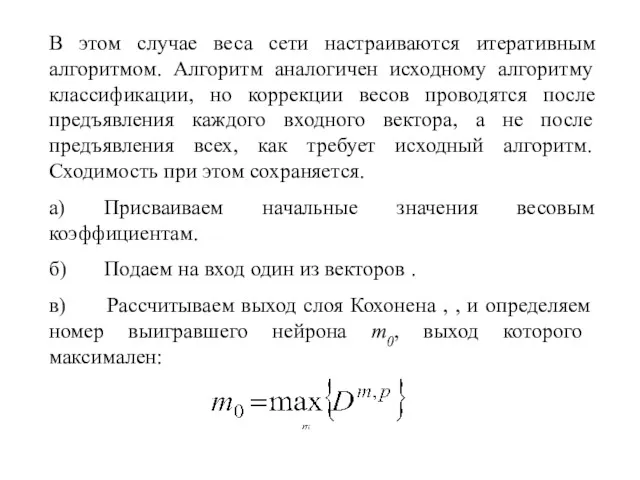

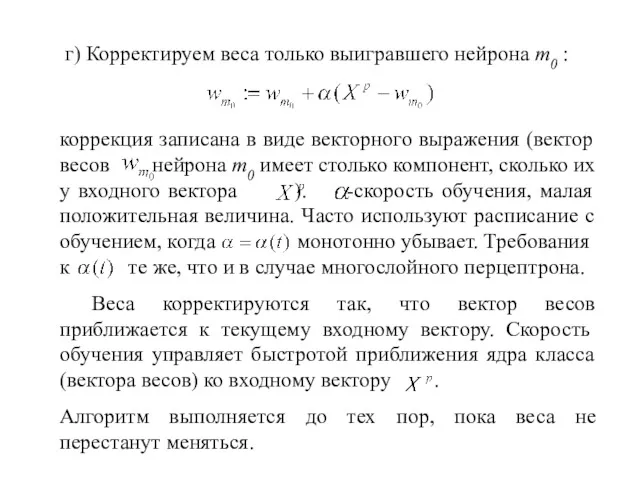

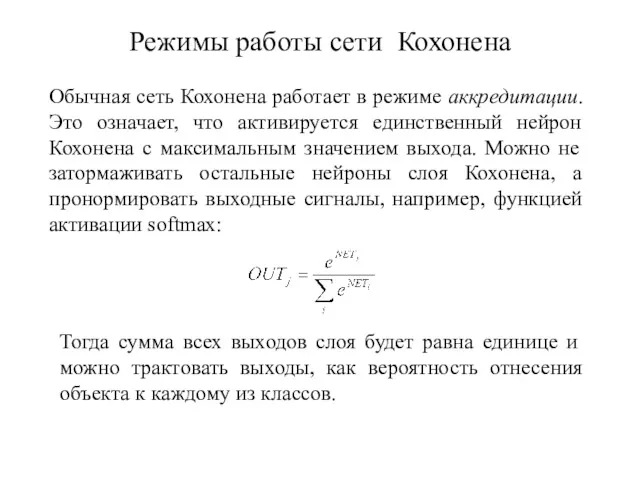

задачу. Выберем в качестве входных данных вектор параметров единственного объекта. Результатом работы сети будет код класса, к которому принадлежит предъявленный на входе объект. В нейросетях принято кодирование номером канала. Поэтому сеть будет иметь M выходов, по числу классов, и чем большее значение принимает выход номер m0 , тем больше "уверенность" сети в том, что входной объект принадлежит к классу m0. Каждый выход можно будет трактовать как вероятность того, что объект принадлежит данному классу. Все выходы образуют полную группу, т.к. сумма выходов равна единице, и объект заведомо относится к одному из классов. Выберем евклидову меру близости. В этом случае ядро класса, минимизирующее сумму мер близости для объектов этого класса, совпадает с центром тяжести объектов:

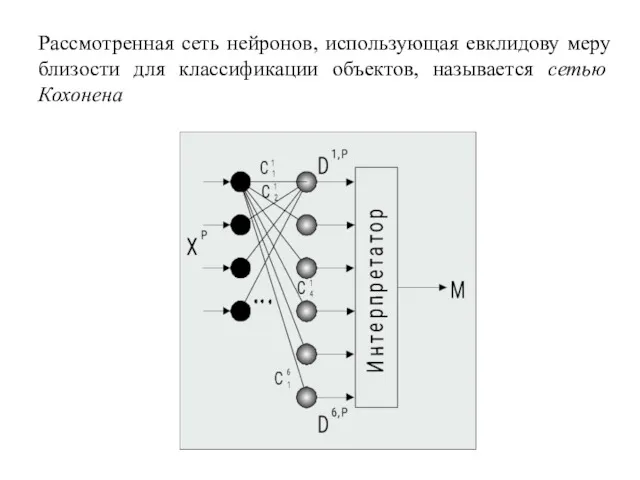

Сеть Кохонена

Порівняння раціональних чисел. Математика. 6 клас

Порівняння раціональних чисел. Математика. 6 клас Угол между скрещивающимися прямыми

Угол между скрещивающимися прямыми Урок математики Решение задач

Урок математики Решение задач урок математики

урок математики Точечные перфокарты.

Точечные перфокарты. Итоговый тест по математике

Итоговый тест по математике Числовые последовательности

Числовые последовательности Уравнение окружности (9 класс)

Уравнение окружности (9 класс) Практическое применение знаний по математике, связанных с сельским хозяйством

Практическое применение знаний по математике, связанных с сельским хозяйством Урок математики в 1 классе на тему Приёмы сложения и вычитания, основанные на знании нумерации чисел

Урок математики в 1 классе на тему Приёмы сложения и вычитания, основанные на знании нумерации чисел Круглые числа. Состав числа 9. Сравнение выражений

Круглые числа. Состав числа 9. Сравнение выражений Урок Числа от 10 до 20

Урок Числа от 10 до 20 Вычитание чисел (часть 1)

Вычитание чисел (часть 1) Применение признаков равенства треугольников при решении задач

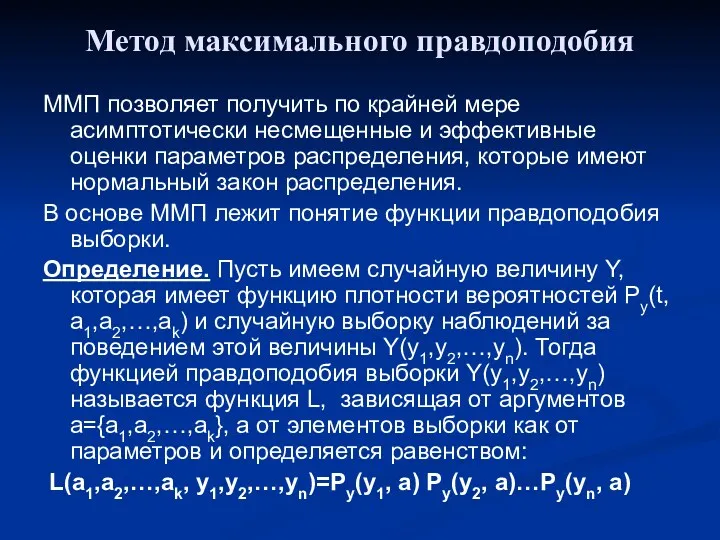

Применение признаков равенства треугольников при решении задач Метод максимального правдоподобия

Метод максимального правдоподобия Формирование УУД на различных этапах урока математики по ТДМ.

Формирование УУД на различных этапах урока математики по ТДМ. Преобразование графиков тригонометрических функций

Преобразование графиков тригонометрических функций Дифференциальные уравнения и их применение в медицинской практике

Дифференциальные уравнения и их применение в медицинской практике Второй признак равенства треугольников

Второй признак равенства треугольников Элементы матанализа. Применение производной при исследовании функции

Элементы матанализа. Применение производной при исследовании функции Таблица деления на 3

Таблица деления на 3 Функция её свойства и график

Функция её свойства и график Ряды динамики. Статистика

Ряды динамики. Статистика Vienkāršās formas

Vienkāršās formas Математический КВН

Математический КВН Вписані і центральні кути

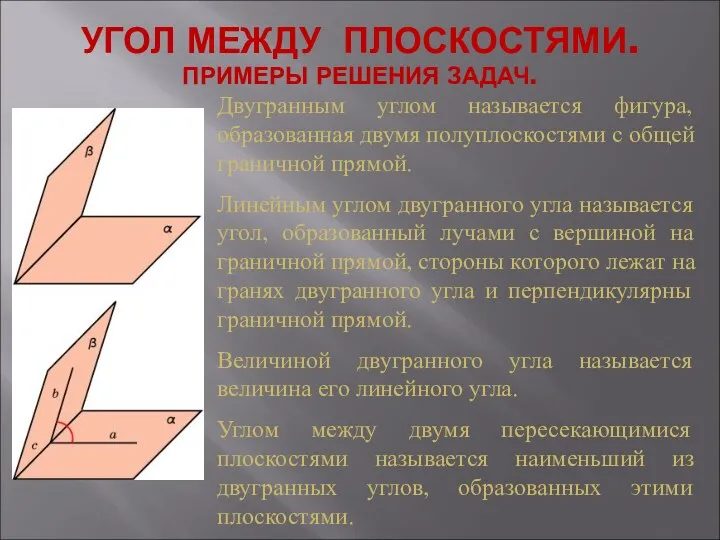

Вписані і центральні кути Угол между плоскостями. Примеры решения задач

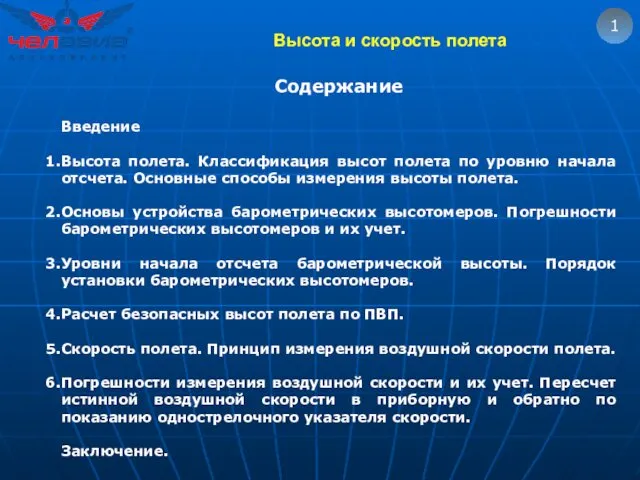

Угол между плоскостями. Примеры решения задач Высота и скорость полета. (Тема 6)

Высота и скорость полета. (Тема 6)