Содержание

- 2. ИНС Иску́сственные нейро́нные се́ти представляют собой математические модели, а также их программные или аппаратные реализации, построенные

- 3. Применение аппроксимация функций на основе ряда данных; распознавание образов; кластеризация и классификация данных; обучение в области

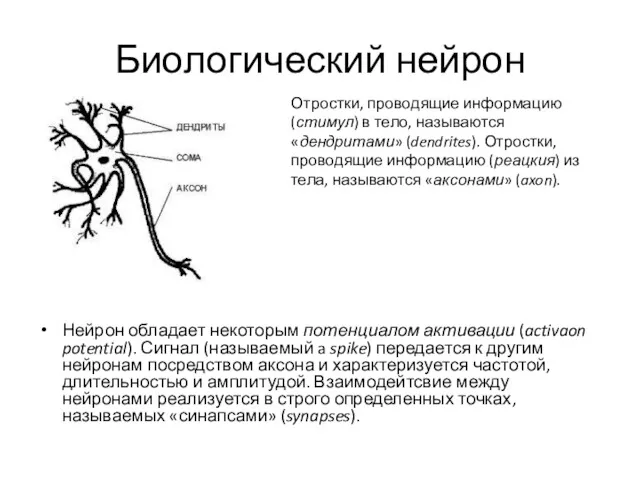

- 4. Биологический нейрон Нейрон обладает некоторым потенциалом активации (activaon potential). Сигнал (называемый a spike) передается к другим

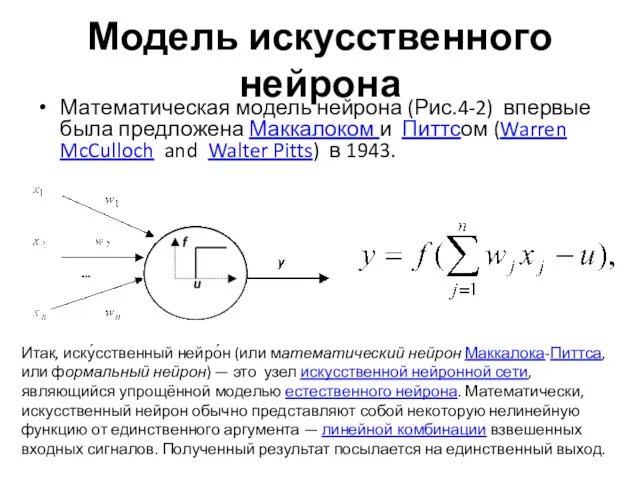

- 5. Модель искусственного нейрона Математическая модель нейрона (Рис.4-2) впервые была предложена Маккалоком и Питтсом (Warren McCulloch and

- 6. От нейрона к системе нейронов ИНС может рассматриваться в виде взвешенного направленного графа (weighted directed graph),

- 7. Архитектура С учетом архитектуры ИНС могут быть разделены на два базисных класса: сети с прямым распространением

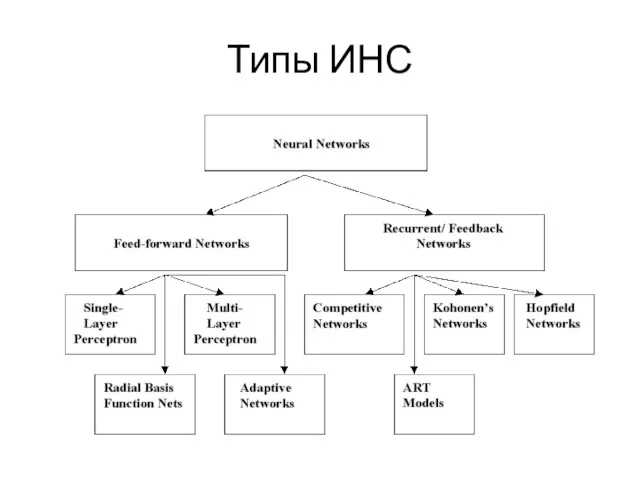

- 8. Типы ИНС

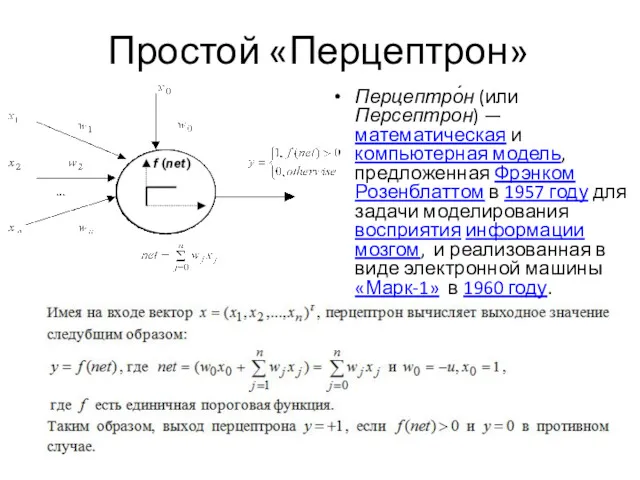

- 9. Простой «Перцептрон» Перцептро́н (или Персептрон) — математическая и компьютерная модель, предложенная Фрэнком Розенблаттом в 1957 году

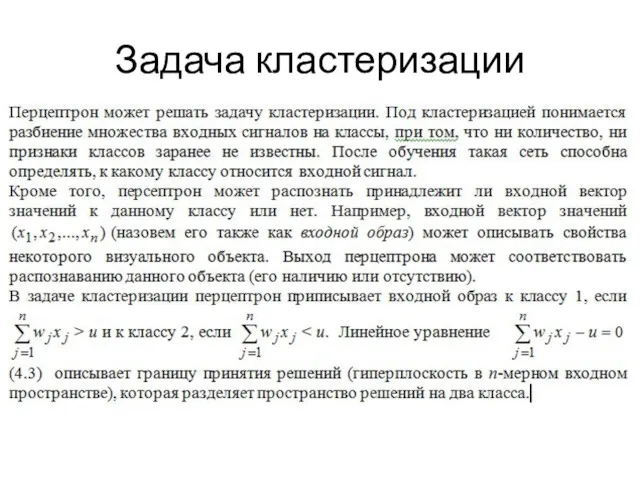

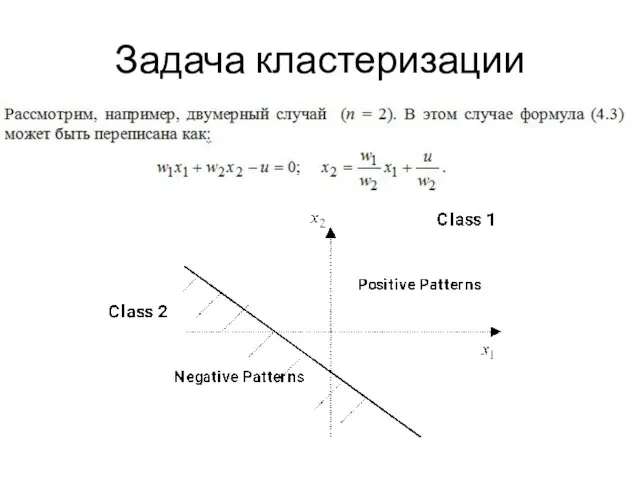

- 10. Задача кластеризации

- 11. Задача кластеризации

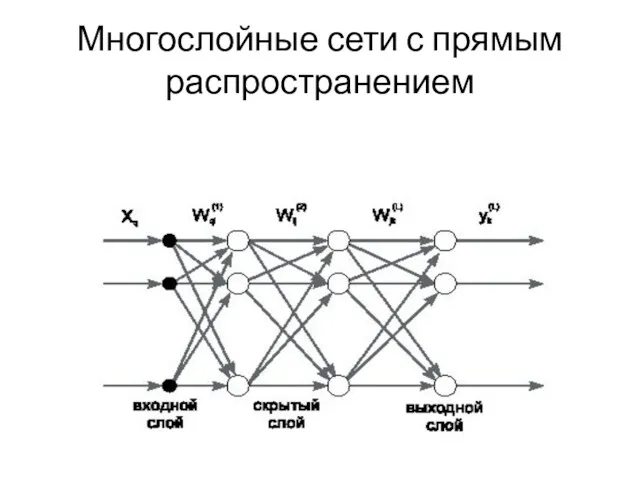

- 12. Многослойные сети с прямым распространением

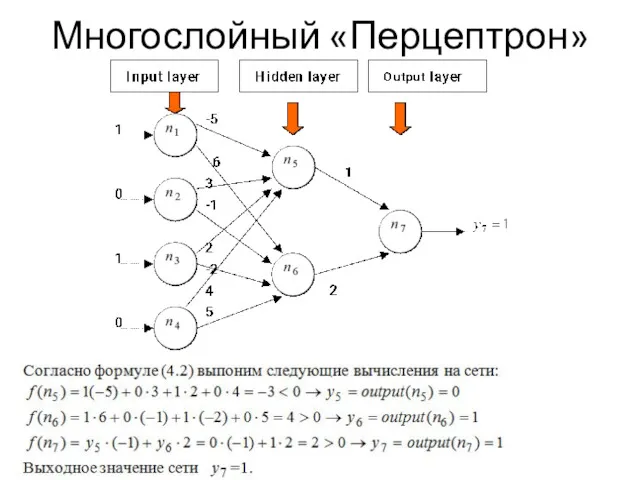

- 13. Многослойный «Перцептрон»

- 14. Многослойный перцептрон как универсальный аппроксиматор Теорема существования (Existence Theorem , Hornik и др,. 1989): MLP может

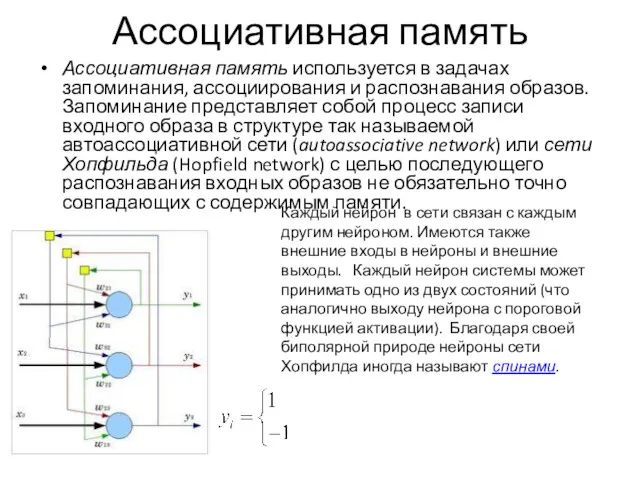

- 15. Ассоциативная память Ассоциативная память используется в задачах запоминания, ассоциирования и распознавания образов. Запоминание представляет собой процесс

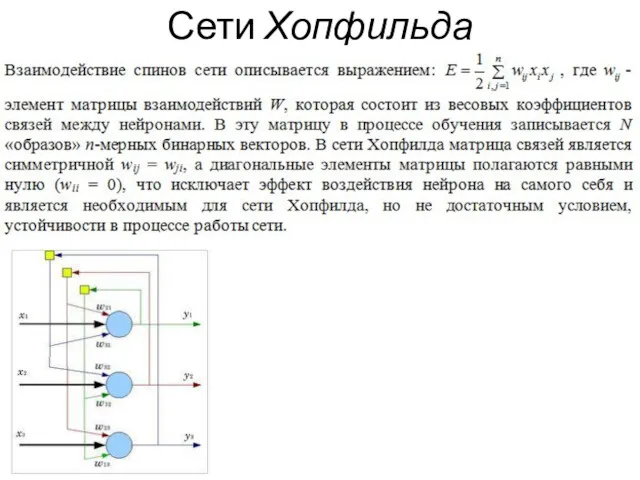

- 16. Сети Хопфильда

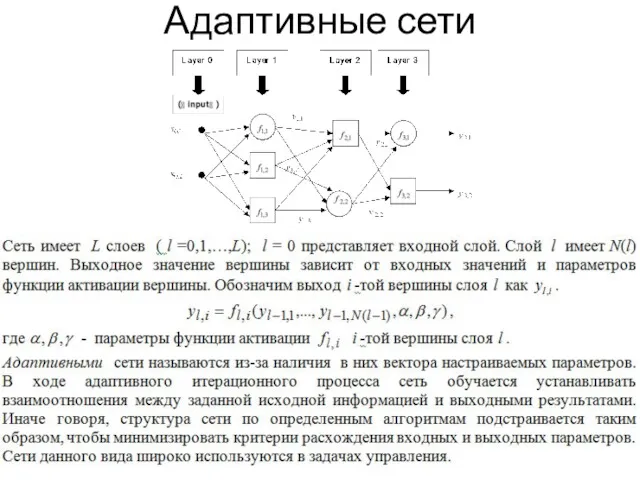

- 17. Адаптивные сети

- 18. Нечеткие нейронные сети для задач управления

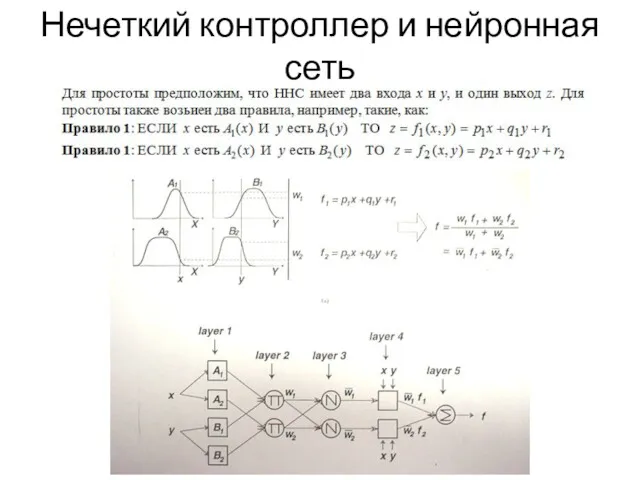

- 19. Нечеткий контроллер и нейронная сеть

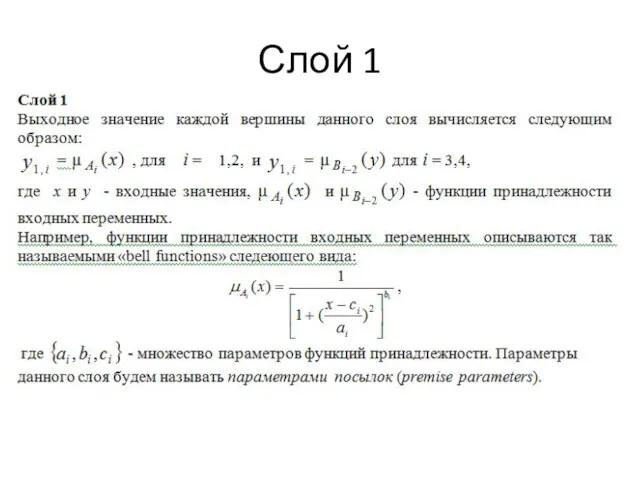

- 20. Слой 1

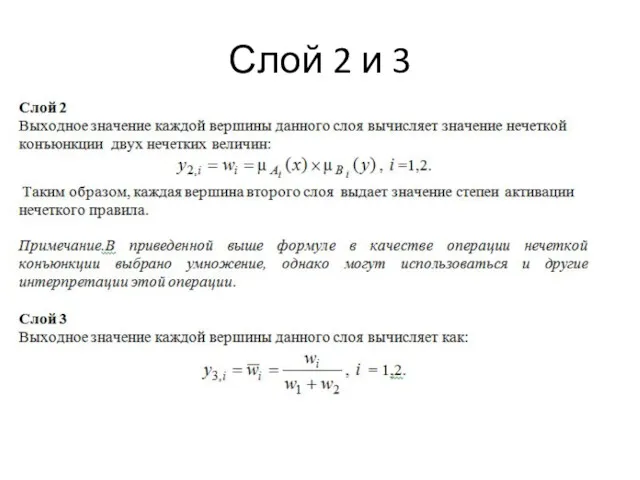

- 21. Слой 2 и 3

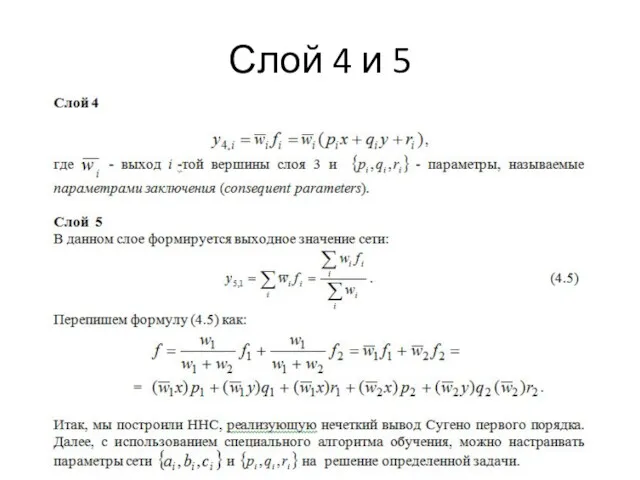

- 22. Слой 4 и 5

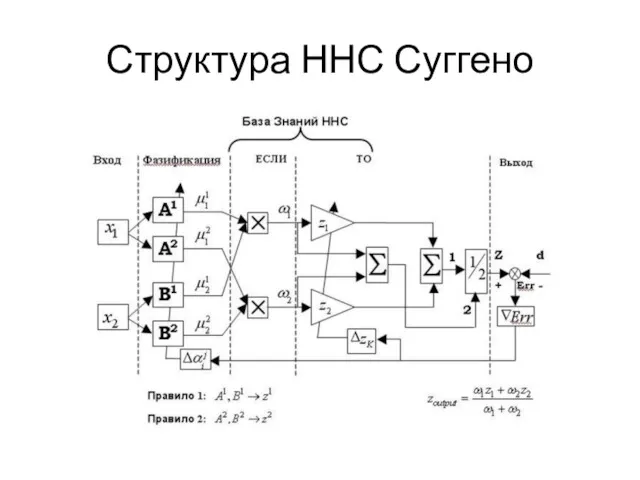

- 23. Структура ННС Суггено

- 24. Заключение

- 25. Заключение

- 26. Обучение сети

- 27. Супервизорное

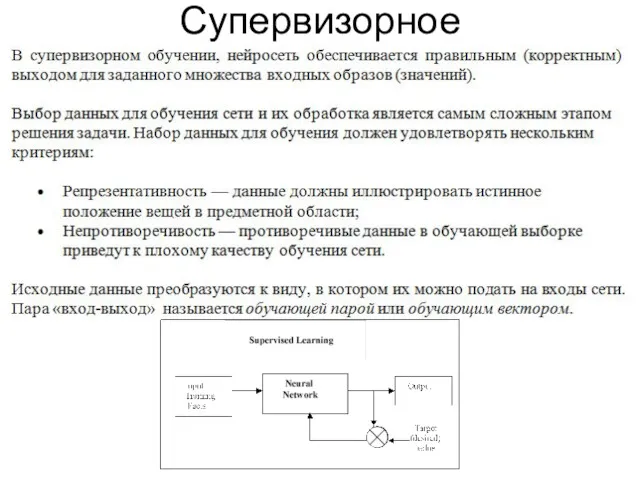

- 28. Супервизорное

- 29. Несупервизорное обучение (обучение без учителя)

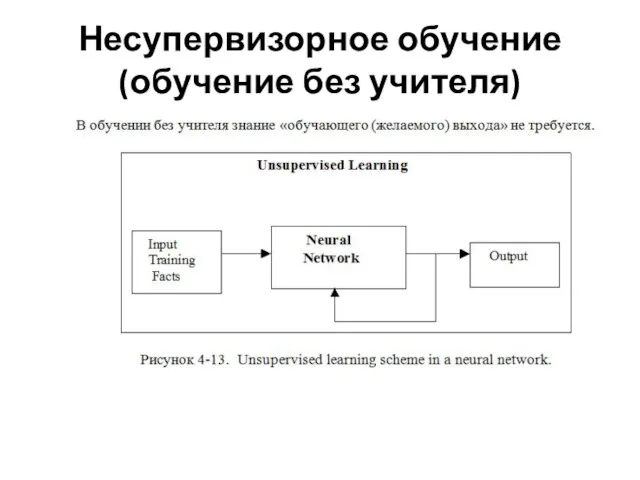

- 30. Несупервизорное обучение

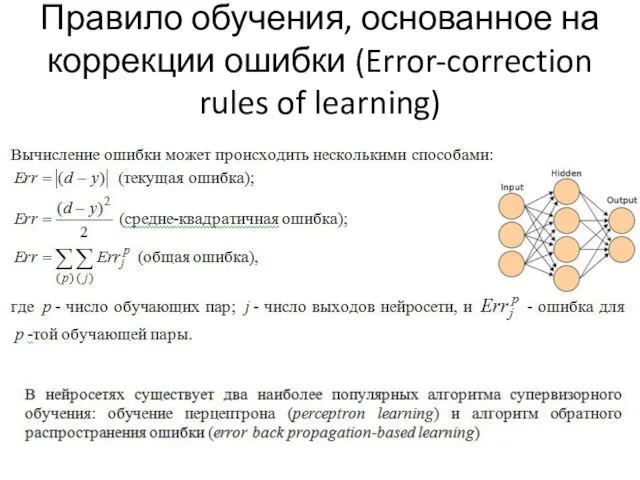

- 31. Правило обучения, основанное на коррекции ошибки (Error-correction rules of learning)

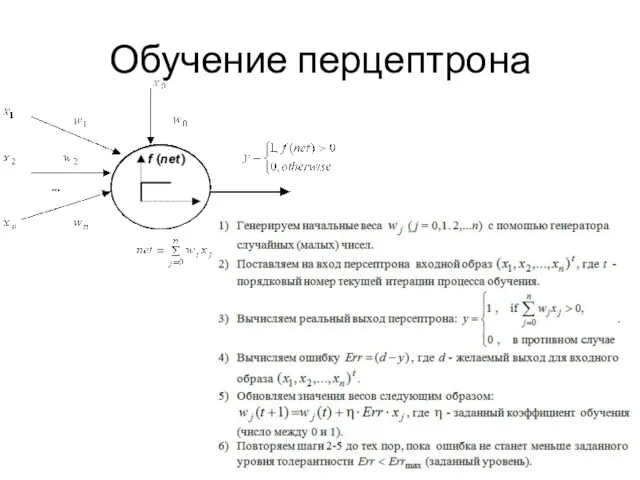

- 32. Обучение перцептрона

- 33. Теорема сходимости Перцептрона Теорема сходимости перцептрона, описанная и доказанная Ф. Розенблаттом показывает, что элементарный перцептрон, обучаемый

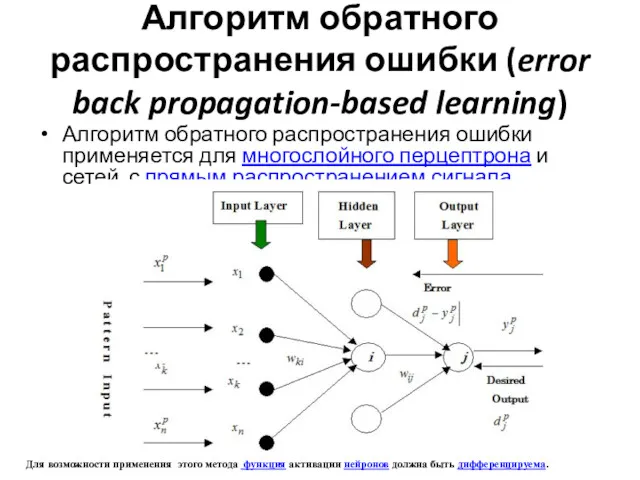

- 34. Алгоритм обратного распространения ошибки (error back propagation-based learning) Алгоритм обратного распространения ошибки применяется для многослойного перцептрона

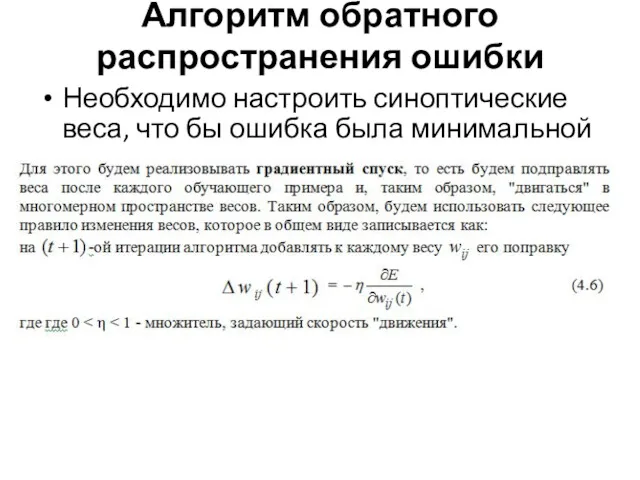

- 35. Алгоритм обратного распространения ошибки Необходимо настроить синоптические веса, что бы ошибка была минимальной

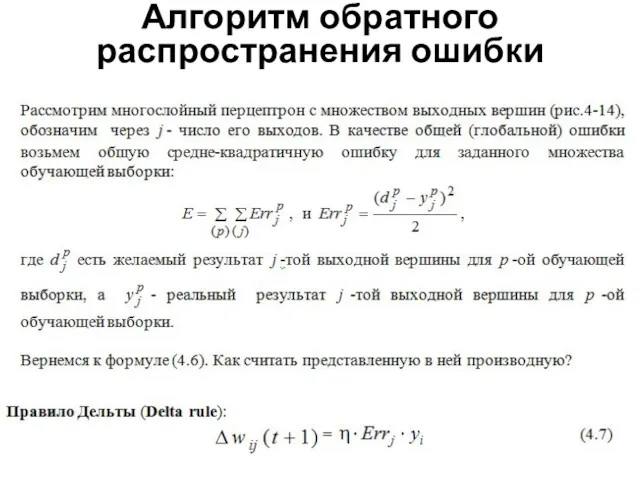

- 36. Алгоритм обратного распространения ошибки

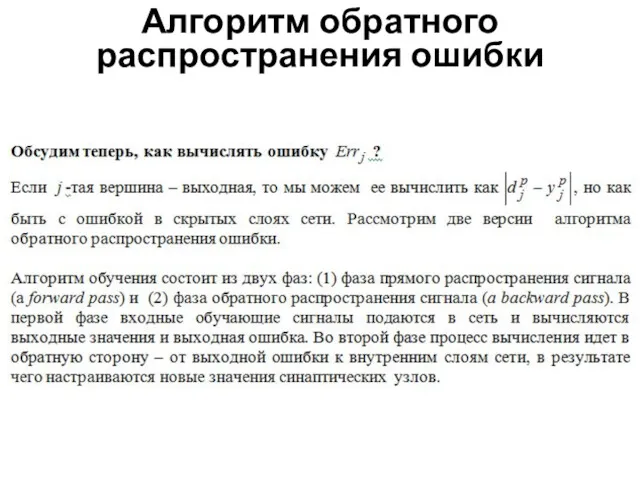

- 37. Алгоритм обратного распространения ошибки

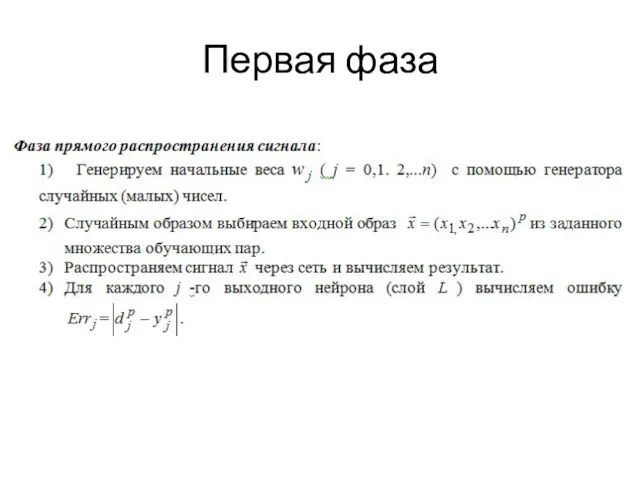

- 38. Первая фаза

- 40. Скачать презентацию

Примеры способов определения понятий в математике в начальной школе

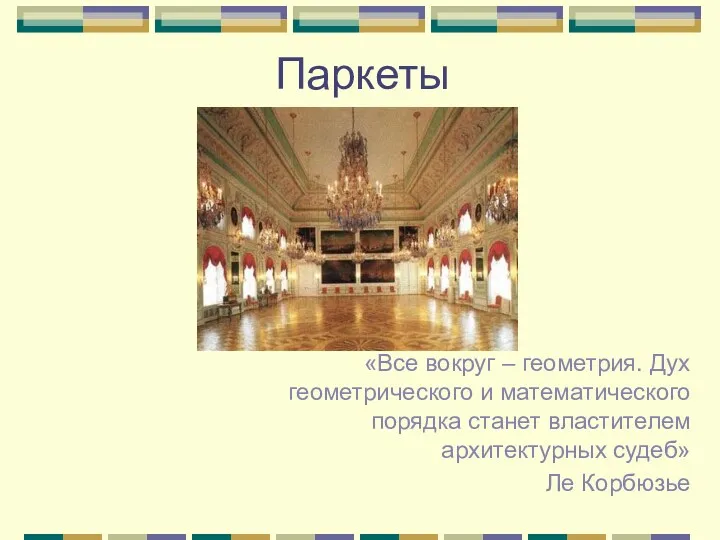

Примеры способов определения понятий в математике в начальной школе Паркеты

Паркеты Проверка вычислительных навыков

Проверка вычислительных навыков Цепи Маркова. (Лекция 2)

Цепи Маркова. (Лекция 2) Параллельность прямых в пространстве

Параллельность прямых в пространстве Решение задач на готовых чертежах. Теорема Пифагора

Решение задач на готовых чертежах. Теорема Пифагора Дидактические игры на уроках математики

Дидактические игры на уроках математики Смеси и проценты. Математика. 6 класс

Смеси и проценты. Математика. 6 класс Теорема о пересечении высот треугольника

Теорема о пересечении высот треугольника Десятичная запись дробей

Десятичная запись дробей Площадь многоугольника. Свойства площадей

Площадь многоугольника. Свойства площадей Виды углов

Виды углов уравнение

уравнение Открытый урок по математике в четвертом классе по системе Л.В. Занкова

Открытый урок по математике в четвертом классе по системе Л.В. Занкова Интегрированный урок Думаем, решаем, анализируем в волшебной стране (математика, литературное чтение)

Интегрированный урок Думаем, решаем, анализируем в волшебной стране (математика, литературное чтение) Задачи раскраски графов. Вершинная раскраска

Задачи раскраски графов. Вершинная раскраска Разложение на простые множители

Разложение на простые множители Интерактивная игра на тему Тик-так. Изучаем время для детей подготоовительной группы детского сада

Интерактивная игра на тему Тик-так. Изучаем время для детей подготоовительной группы детского сада Одночлен и его стандартный вид. 7 класс

Одночлен и его стандартный вид. 7 класс Действия над векторами

Действия над векторами Основные понятия алгебры логики

Основные понятия алгебры логики Наибольший общий делитель. Составные числа

Наибольший общий делитель. Составные числа Тренажёр по математике (часть работы).

Тренажёр по математике (часть работы). Функция y=cos х, её свойства и график

Функция y=cos х, её свойства и график Луч. Числовой луч

Луч. Числовой луч Интеллектуальная игра по математике

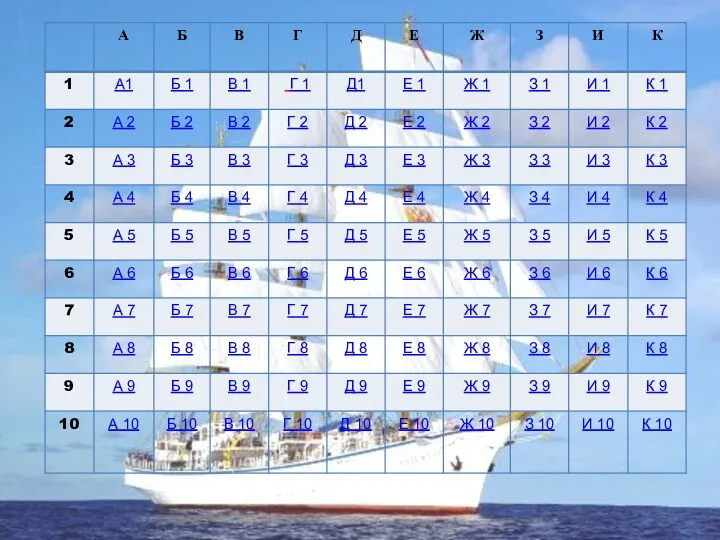

Интеллектуальная игра по математике 10 способов решения квадратных уравнений

10 способов решения квадратных уравнений Сложение и вычитание смешанных чисел. Урок математики в 5 классе

Сложение и вычитание смешанных чисел. Урок математики в 5 классе